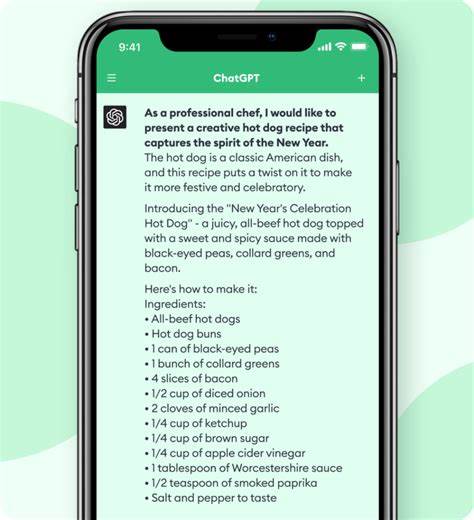

近年来,大型语言模型(LLMs)已经成为人工智能发展的重要里程碑。它们在自然语言处理领域展现出令人瞩目的进步,从文本生成到机器翻译,再到问答系统,LLMs改变了人们与机器交互的方式。然而,伴随着迅速普及和广泛应用,围绕这些技术的批评声也越来越多,部分人认为大型语言模型“被过度吹捧”或者“未达到预期”,甚至存在性能和伦理的严重问题。那么,究竟大型语言模型是否真的被过度批评?或者它们的争议背后隐藏着更深层的技术与社会问题?通过对多方观点和现状的梳理,可以更全面地理解这一命题。 大型语言模型的技术基础源于深度学习和海量数据训练,这使得它们在处理自然语言时具有极强的泛化能力和灵活性。比如,GPT系列、BERT以及其他开源模型在很多场景下表现出色,能够输出高质量的文章摘要、代码辅助生成甚至创造性写作,极大地提升了相关行业的效率。

不过,技术上的卓越表现并不意味着它们不存在缺陷和限制。 首先,LLMs在实际应用中仍存在不稳定性。尽管能够生成连贯流畅的语言,但它们有时会出现语义偏差、产生虚假信息,甚至在复杂推理任务中表现不佳。许多批评声音正是针对这些问题,认为当前的LLMs未能持续稳定地满足高标准的专业需求。例如,在法律、医疗等高风险领域,错误信息可能带来严重后果,这使得模型的可信度和安全性受到怀疑。 此外,大型语言模型的训练和运行需要消耗大量计算资源,带来巨大的能源消耗和环境负担。

它们的算力需求不仅推高了成本,也引发了公众对其可持续性和环保问题的关注。有人批评这类技术“过于奢侈”,不符合绿色科技的发展方向,呼吁行业更注重生态影响和节能减排。 另一方面,值得注意的是,对于大型语言模型的批评有时源于对其能力的误解和过高期待。某些用户希望模型能成为全能“智能助手”,但当前技术仍属于狭义人工智能范畴,并没有真正实现人类般的认知理解。技术本身的局限性和研究进展的不均衡,使得大众对其过度期待,反而导致失望和负评。这种现象在新技术兴起阶段十分常见。

因此,可以说大型语言模型的批评既有合理成分,也存在因认知偏差带来的过度怀疑。从技术角度来看,它们确实还有很大提升空间,需要在准确性、稳定性以及对上下文的理解能力方面进一步完善。从社会层面而言,如何平衡它们带来的便利与潜在伦理风险,制定合理的监管规范,也是亟需解决的课题。 面对批评,业界也在积极探索改进方案。例如,通过引入人机协同机制来减少错误生成,开发更加高效的模型结构以降低计算资源消耗,强化模型的安全审查和透明度,渐进式地解决性能与责任问题。同时,普及人工智能素养,理性看待技术进步,有助于消除人们对LLMs的误解和不切实际的偏见。

从长远角度看,大型语言模型作为人工智能发展的核心驱动力,将继续推动语言理解、信息处理以及人机交互的革新。它们的价值不仅体现在当前的应用成效,更在于激发科研创新和促进跨领域融合。尤其是在教育、医疗、法律、创意产业等领域,LLMs的潜力仍未完全释放,未来具备更广阔的应用前景。 综合来看,大型语言模型并非如部分观点所称的“被过度吹捧”或“毫无价值”,其存在的问题和不足也并非完全不可克服的障碍。更为重要的是,正确认识它们的优势与限制,推动技术健康发展,避免盲目乐观或过度怀疑,才是促进人工智能与社会共同进步的关键。未来随着技术的不断演进和监管机制的完善,LLMs有望成为更为稳定、智能且环保的解决方案,真正造福全人类。

。