回望过去几年,人工智能领域,尤其是大型语言模型(LLM)的发展堪称飞速。自从GPT-3成为公众焦点之后,我们目睹了从少量开放模型到众多高性能开源模型的不断涌现,整个生态系统经历了深刻的变革。这种变革不仅推动了技术的进步,也极大地丰富了用户体验和应用场景。最初,开放世界中的大型语言模型几乎难觅踪影。BLOOM作为一款拥有1760亿参数的开源模型,成为早期的代表之一。尽管其性能无法与当时的GPT-3相比,但它点燃了业内人士对未来可能性的热情。

同时,本地化AI社区还仅由数千名爱好者组成,他们怀着好奇与热忱,默默注视着如OpenAI等大型机构的技术飞跃,渴望将强大语言模型引入自己的设备,尝试实现本地运行。Meta的Llama-1模型泄漏事件成为AI界的一个重要节点。它虽未真正超越GPT-3.5的性能,但开启了构建小型高效模型的新时代。通过Llama.cpp这类工具的诞生,人们终于能够在CPU上运行大型语言模型,这极大地降低了技术门槛,同时激发了更多开发者和研究者的兴趣。GGML量化(后更名为GGUF)的出现,再次推动了模型的轻量化与可访问性。它让各种规模的模型能够更易于部署在更广泛的硬件平台上,而不再依赖昂贵的GPU资源。

与此同时,众多公司纷纷加入通用人工智能(AGI)的竞赛,Mistral推出的mistral-7b和mixtral模型充分展示了混合专家模型(MoE)的潜力,这些创新使得性能与效率达到新的平衡。社区贡献者如TheBloke不断发布模型的量化版本和调优成果,为大众提供了更多选择。然而,这背后也伴随着不确定性,TheBloke的突然消失让人们心生惋惜,也提醒我们社区生态的脆弱。有趣的是,很多开源项目的命名带有浓厚的爱好者色彩,“oobabooga”(本名Text Generation Web UI)便是其中的典型代表。它们承载了社区热情和创新精神,象征着那个非商业驱动、纯粹为兴趣而生的时代。随着时间推进,商业力量逐渐介入AI领域,市场化需求和盈利动机开始塑造技术走向。

虽然这一趋势带来更多资源和动力,但对于许多开源模型和工具来说,依然保持免费和开放的精神成为许多爱好者坚持的底线。LoRA和QLoRA作为一种高效的微调技术,成为社区的又一突破。它们极大降低了模型个性化定制的门槛,使得用户能够轻松训练特定任务或角色的语言模型。无论是学术研究、企业应用,还是简单的角色扮演,这些技术极大丰富了互动体验。然而,伴随模型能力的提升,安全性问题也日渐突出。如提示注入攻击开始被挖掘,用户绕过模型限制的手段层出不穷,促使研究者在守护与开放之间寻找新的平衡。

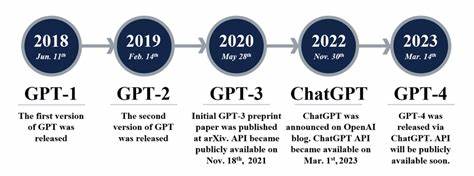

如今,经过三年多的发展,开源大语言模型的数量激增,开放权重(open-weight)已成为社区赋能的重要标志。然而,真正意义上的开源(open-source)模型仍然较为稀少,许多模型或因许可限制或因商业利益,无法做到完全公开透明。围绕这些模型,开发了大量的工具、包装和应用,虽有不少项目因维护资源有限而暂停,但整体氛围依旧充满活力。GPT-4时代的到来带来了前所未有的研究热潮和模型创新。各类论文和新模型层出不穷,让人猝不及防。尽管距离所谓的奇点尚有距离,这股技术进展的快节奏和对知识更新的高需求,让人深刻感受到AI领域的魅力与挑战。

OpenAI曾以“危险性”为由拒绝开源GPT-3,而如今,比GPT-3更加强大且开放的模型层出不穷,社会并未陷入混乱,似乎印证了技术责任与监管共同进步所带来的秩序保障。实际上,用户对本地运行模型的需求推动了硬件市场的变革。许多人关心的“70亿参数的模型是否能在Nvidia 3090显卡上运行”这一问题,反映出对硬件性能和价格的实际期待。虽然Nvidia目前几乎占据GPU市场的主导地位,但随着AMD、Intel、Apple等厂商的持续竞争,未来硬件生态势必变得更加多元与合理。总结这段旅程,令人感慨的不仅是技术的进步,更是社区中的每一次知识分享与热情传递。从昔日几个千人爱好者起步,到如今数以万计的开发者、研究者和用户共同推动AI生态的发展,这条路上凝聚了太多人的智慧和汗水。

展望未来,大型语言模型将继续深入到更多实际应用领域。跨模态能力、多语言理解、个性化交互、模型安全与道德等话题,将成为科研和产业关注的重点。更加开放、包容和协作的社区环境,将为创新提供沃土,同时也呼唤更完善的监管机制与责任担当。我们正站在变革的浪潮前端,继续见证AI赋能人类社会迈向新纪元的历程。