在数字化时代,音频数据的生成量呈现爆炸式增长,尤其是在客户服务中心、内容创作平台及语言模型训练等场景中,每小时产生的录音和音频文件数量巨大。传统的语音转录服务多依赖于收费昂贵的专有API,既增加了成本负担,也在处理速度上存在瓶颈。近期,随着开放源代码模型性能的提升,一种全新的转录模式应运而生,令业内为之一振。Modal平台宣布利用开源自动语音识别模型将一周音频数据的转录时间缩短至仅一分钟,转录费用低至一美元,开创了行业领先的高效、低价转录新时代。过去几年来,生成式人工智能和大规模深度学习模型的出现,使得智能推理和语音识别技术实现质的飞跃。虽然市面上多以专有API为主流服务,但最近开源模型已在准确率和处理速度方面逐渐赶超甚至超越传统方案。

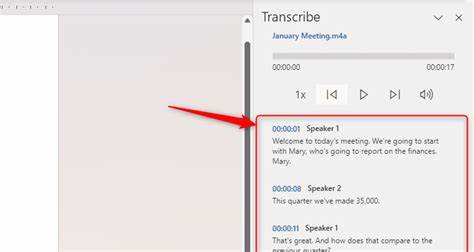

特别是在NVIDIA的Parakeet和Canary模型、Kyutai的STT等开源项目的推动下,语音识别的误差率大幅下降,同时支持多语言、语音活动检测及字级时间戳等功能,为多样化应用提供了有力保障。Modal团队通过对比测试发现,专有API每分钟音频收费约为0.4美分,而Modal基于A100或L40S GPU的云计算资源每分钟成本仅为0.04美元。结合模型的极高实时因子(RTFx),即每分钟可处理音频的数量,最终实现了转录成本的百倍削减。具体实验中,Modal使用NVIDIA的parakeet-tdt-0.6b-v2(英文模型)与canary-1b-flash(多语言模型)对一周时长的ESB基准测试音频进行处理,最终得到了转录速度超过100倍,同时准确率基本持平甚至略优于专有API的结果。该成果意味着海量音频数据可以在极短时间内转为文本,为聊天记录、客户服务录音、内容归档等业务场景节省了大量人力和时间成本。Modal团队详细阐述了其在系统架构、数据调度、请求批处理等方面的优化经验。

批量转录服务针对需要快速处理大量录音的企业场景设计,如呼叫中心实时录音监管、电台或播客批量转写、多语种大规模语料标注等。与低延迟需求的实时转录不同,批量转录侧重于最大化吞吐率和降低单位时间成本。通过动态调整任务划分,将音频文件均匀分配给多个GPU工作节点,保证每个节点处理时间和资源利用均衡,有效减少等待时间。音频批次内进一步根据片段时长排序,优化GPU内存使用和并行计算效率。数据传输环节也进行细致设计,采用多线程下载策略、合理的缓存和调用方式,确保网络带宽最大化利用,缩短中间环节耗时。团队还通过实验确定不同GPU型号及节点数量的组合,在成本与速度间取得最优平衡,形成多样化选择方案,满足不同客户需求。

值得一提的是,Modal的转录方法基于开源技术,排除了对专有API的依赖,这意味着企业能够避免被供应商锁定,提高系统灵活性和安全性。此外,借助开源社区的持续升级,整体技术性能具备较强的可持续发展潜力。在实际应用中,Modal的服务已被Substack、Zencastr等多家对转录需求巨大的互联网企业采用,显著缩短了内容上线周期,降低了运营成本。未来,随着模型不断升级和云计算资源费用的进一步下降,结合更多自动化流程,语音识别服务将更加普及。Modal表示,用户只需几行Python代码和简单配置,即可在其平台上快速部署高性能批量转录服务。此举不仅降低了技术门槛,也促进了语音数据的广泛利用,为智能客服、内容分析、多语言支持等领域带来了深远影响。

总的来说,借助开源自动语音识别模型及优秀的云资源调度,Modal展示了一种革新传统语音转录方案的可能。实现了以极低成本转录海量音频的同时,保证了行业领先的转录精度和速度,真正做到在一分钟内转录一周音频仅花费一美元。这不仅降低了企业的运营成本,也推动了语音技术的普及和应用创新。未来,这类技术将继续推动人工智能在各行各业的深度融合,助力数字经济升级和智能社会建设。