随着人工智能技术的迅猛发展,大型语言模型(LLM)正逐渐成为人们日常生活和工作中不可或缺的助手。无论是在信息查询、写作辅导还是事实核查等领域,LLM都展现出强大的能力。然而,伴随着其普及,用户常常遇到这样一种现象:LLM在给出答案时似乎会出现"错误"或"矛盾"的情况,给用户带来困惑和质疑。许多人甚至质疑这些回答是否可信,或者模型是否本质上存在错误。但事实上,LLM的这些"错误"往往是一种过程中的产物,反映的是信息处理的复杂性和多阶段验证的必要性。理解这一点,有助于用户更科学地使用AI助手,更有效地进行信息核实。

传统观点一般将LLM的错误归结为"幻觉" - - 即模型凭空捏造不存在的事实。但越来越多的研究表明,所谓幻觉的定义正在淡化和模糊,初级回答中的错误并非毫无根据的捏造,而往往是信息整合未完成、证据权重偏颇的结果。在处理复杂或多源信息时,LLM表现出的不稳定答案,恰恰类似于人类在面对纷繁复杂信息时的初步判断。人们常常会先从社会媒体、网络流传的消息或非正式渠道获取线索,形成初步认知,随后逐渐过滤、深挖、比较各种证据,最终得出较为准确的结论。LLM的回答过程亦是如此。起初,它通过训练数据和搜索结果提供一个初步答案,可能偏重于主流或现有的主观描述,未必能直击事实真相。

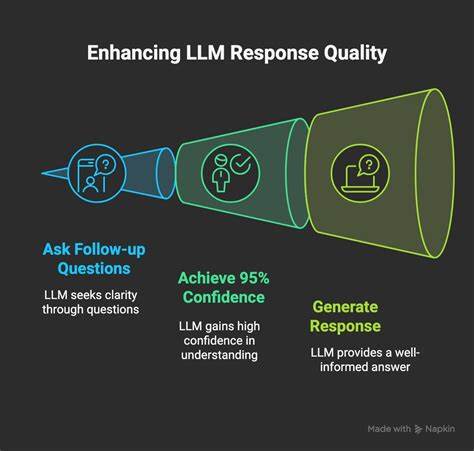

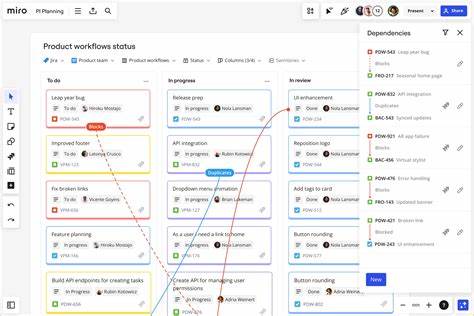

然而,若用户不满足于这个"第一眼看起来"的回答,能知道如何引导模型进行多轮追问或"反复斟酌",那么得到更贴近事实的答案就变得可能。迭代是突破LLM回答局限性的关键环节。通过设计针对性的后续提问,例如"请详细列举支持和反对该观点的证据","分别梳理专家、媒体和社交平台的说法差异",或者"结合最新信息更新这个结论",模型能够对已有信息作出更加综合且分门别类的整理。这一过程像极了经验丰富的事实核查员的工作方法:先了解该事件传播的主流版本,接着进行证据搜集和交叉验证,最终形成综合性判断。相较于一开始便期待模型给出准确无误的终结性答案,采用迭代的思维和交互策略既符合模型的设计逻辑,也更贴合现实中信息检验的复杂过程。反过来,如果用户只停留在第一轮的答案,那么错误和矛盾便容易被误读为模型本身的缺陷。

事实上,这往往是"完成度不足"的反映,而非机理上的错误。理想状态下,人机交互应当是一种动态、演进式的过程,用户通过引导、提示和补充信息,不断提升内容的准确度和深度。尽管有批评者认为AI系统本质上仅仅是基于概率分布的模式匹配,无法真正"理解"事实真相,但这一认知误区却忽视了实用主义层面的价值:即便AI没有真正具备人类意义上的推理能力,当它被设计成允许多轮查询和信息整合时,答案的准确性和逻辑连贯性可以得到显著提升。提升公众的信息素养同样重要。很多普通用户缺乏基本的搜索与判断技巧,容易陷入第一层次的信息表面,误以为AI给出的答案就是最终真理。这种误解导致对AI的不信任增多,甚至发生诸如"AI输出不可依赖""AI多次给出谬误"之类的极端看法。

然而,正如传统的事实核查工作需要反复查证和深入调查一样,使用LLM的最佳实践也是在于恒常地推动多轮的交互查询,促使模型主动"重新梳理"和"排列事实"。技术层面,推动平台提供更多互动和迭代功能显得尤为紧迫。只有当用户能够便利、顺畅地引导模型重新评估信息,并获得清晰的观点区分与证据呈现,AI才能真正成为增进社会知识共享的有效工具。从教育视角出发,推动学校和企业普及"询问-验证-再询问"的思维模式,有助于将LLM应用提升为一种促进批判性思维和信息觉察能力的手段,而非简单的答案生成机器。总而言之,大型语言模型所表现出的"错误"更多是一种信息处理过程中的自然现象,是初步结论与深度验证之间的一个过渡阶段。用户如果能够意识到这一点,主动采取迭代提问和证据梳理策略,必将在AI交互的实践中收获更加清晰和准确的洞见。

正视这一点对推动AI技术人性化发展、增强大众对人工智能的合理期待具有重要意义。如此,LLM不仅不会沦为"误导制造器",反而会成为提升全民信息透明度和辨识能力的催化剂。 。