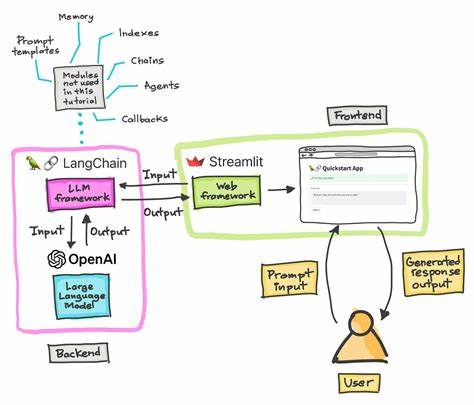

随着人工智能技术的迅猛发展,大型语言模型(LLM)在各领域的应用正在快速扩展。它们不仅改变了自然语言处理的方式,更对后端架构提出了新的挑战和机遇。在试图简化API编排的过程中,我们团队竟意外地开发出了一套专为大型语言模型设计的后端框架——Cosmo Plugins。这套框架不仅推动了API网格与GraphQL联邦发展的前沿,也为企业实现智能化数据调用和服务整合提供了全新路径。如今,理解这一技术的原理和优势,对于懂得如何抓住AI浪潮机遇的开发者和企业来说,意义非凡。 在数字化转型的大背景下,企业的IT架构正面临着越来越复杂的挑战。

现代企业通常需要管理数十甚至上百个API接口,这些接口分属不同的服务团队,单独管理时效率低下且易出错。传统的微服务架构虽强调服务之间的解耦,但对于API调用的整合与优化仍然存在痛点。正因如此,基于GraphQL联邦的超级图谱(Supergraph)概念应运而生。超级图谱通过将多个服务子图(Subgraph)组合成一个统一的API入口,有效消除了微服务碎片化问题,实现了前端与后端的高效协同。 然而,尽管超级图谱理念先进,实际部署和维护却遇到阻碍。许多企业拥有庞大的遗留API系统,这些以JSON-over-HTTP为主的接口通常不支持GraphQL协议,也无法直接融合到联邦架构中。

改写庞大的API代码库成本高昂且风险巨大,导致超级图谱的广泛应用受限。针对这一难题,Cosmo Plugins巧妙采用了大型语言模型的代码生成能力,自动生成代理代码,将非GraphQL接口无缝映射到 súpergraph中。 这种创新的方法极大地降低了超级图谱的工作量和复杂度。通过将问题拆分成多个小模块,严格限定生成代码的范围和规范,LLM能够高效完成代码代理的自动生成,使得企业无需重写旧有接口便能享受GraphQL联邦的诸多优势。借助哈希科普(Hashicorp)go-plugin框架,Cosmo Plugins保证了插件的稳定性和隔离性,让每个功能模块都运行于独立子进程中,避免了单点故障对整体系统的影响,同时也提升了模块间的解耦性。 Cosmo Plugins另一大亮点是其灵活的部署策略。

企业既可选择将所有插件集成为一个模块化的单体应用,从而方便管理和快速迭代;也可以根据业务需求,将插件拆分成多个独立微服务,支持分布式开发和弹性扩展。这样一种设计让企业既拥有单体应用的管理优势,又能灵活切换到微服务架构,实现架构演进的无缝对接。 插件之间的依赖关系也通过GraphQL联邦标准得到有效管理和自动调度,保证了调用路径的准确无误和数据流的稳定传递。针对依赖问题,路由器(Router)组件负责在运行时正确解析和调用多个插件的接口,使得整个超级图谱具备强大的扩展能力和逻辑一致性。 以实际操作为例,开发者只需创建新的模块定义架构的GraphQL schema,并通过预设的Cursor规则,调用LLM完成相关代码的自动生成和适配。随后生成的插件通过路由器进行管理和调用,完成了从设计到运行的闭环。

这种较低技术门槛和高度自动化的流程,大大加速了开发效率,缩减了传统开发周期。 从更宏观角度看,Cosmo Plugins的诞生标志着一个重要趋势:人工智能与后端系统架构的深度融合。LLM不再仅仅是文本生成工具,而是成为了一种具备自主代码编写与逻辑推理能力的生产力助手。未来,更多复杂的API编排、服务整合任务都将逐渐依赖这种智能化框架,从而打造更加灵活、智能、可扩展的后端服务生态。 对企业而言,采用这类创新框架无疑带来诸多实际收益。首先,旧有API的无缝接入降低了技术债务以及系统升级的门槛。

其次,集中的超级图谱入口简化了服务发现和整合流程,提升了维护效率和系统性能。再者,多语言模型驱动的代码生成减少了人为编码错误,提升了系统稳定性和安全性。 最后,Cosmo Plugins作为一种可扩展的后端框架,也为未来的技术创新打开了无限空间。随着生成式AI能力的不断增强,框架可以不断进化,支持更加智能化的规划、调度和优化机制,进一步简化开发者体验并提升企业竞争力。总结而言,我们从简化API编排出发,意外打造出兼顾灵活性与智能化的后端框架,这是大型语言模型技术在企业级应用落地的重要里程碑。相信随着社区参与的不断深入,Cosmo Plugins及类似技术将成为推动下一代后端架构变革的基石,助力更多企业实现数字化转型和智能服务升级。

未来,拥抱智能化后端框架,将是所有技术团队实现高效开发和创新的必由之路。