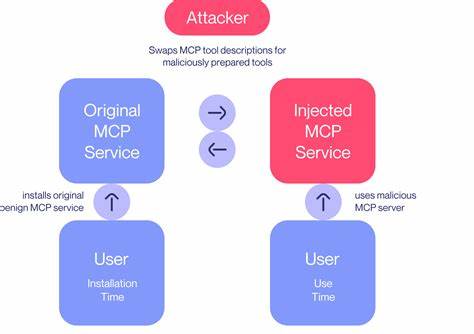

随着大规模语言模型(LLM)在自然语言处理领域的广泛应用,模型上下文协议(Model Context Protocol, MCP)作为连接语言模型与外部工具和数据源的关键桥梁,正日益受到关注。MCP通过使LLM能够调用各种外部工具,极大地提升了模型的实用性和智能化水平,但与此同时,MCP在安全方面暴露出诸多脆弱点,尤其是工具抢占(Tool Squatting)和山寨攻击(Rug Pull Attacks)等安全威胁日益突出。这些攻击不仅破坏了整个生态系统的信任基础,也对人工智能的安全应用构成了严重挑战。 工具抢占,顾名思义,是攻击者利用与合法工具名称相似或者相同的标识注册恶意工具,导致模型误调用这些伪装工具,进而执行未经授权甚至恶意的操作。这一行为不仅扰乱了工具市场秩序,也能够实现对用户数据的窃取和改造,甚至引发更为严重的安全事件。山寨攻击则更具欺骗性,攻击者往往以各种手段诱骗开发者或系统自动集成了恶意工具,进而在关键时刻收回或操控工具权限,导致服务中断甚至数据破坏,给用户带来巨大损失。

保护MCP生态系统免受此类威胁,成为业界亟需解决的问题。针对这一问题,最近提出的创新方法之一是通过增强的工具定义接口ETDI(Enhanced Tool Definition Interface)。ETDI的核心在于引入多重安全机制,包括基于密码学的身份验证技术,确保工具身份的真实可验证;使用不可篡改的版本化工具定义,保证工具的参数和接口信息透明且固定;以及结合OAuth 2.0协议实现的权限管理,细化工具调用的授权范围和时效性。这些措施有效防止了工具被恶意替换或伪造的风险,提升了整个协议的安全性和可控性。 进一步深化防护层次,MCP安全策略还引入了基于细粒度策略的访问控制机制。传统的OAuth范围验证过于静态和粗糙,难以对不同运行时环境和上下文信息做出动态响应。

新的策略型访问控制方案利用专门的策略引擎,依据运行时的具体上下文环境对工具调用权限进行细致评估和限制,实现精准授权。这意味着即使攻击者获得了某些OAuth凭证,也难以超越预设策略进行未经授权的操作,从而极大增强系统的弹性和安全保障。 在实际应用层面,这种多层级防护不仅提升了MCP的可信度,也推动了开源社区与企业对工具安全性的重视。安全的工具定义和控制机制促进了健康的生态发展,激励开发者持续提供合规且高质量的工具,同时保障用户利益和数据安全。对于依赖于语言模型相结合工具进行复杂任务处理的行业,如金融、医疗和智能制造等领域,强化MCP安全成为保障业务安全性和合规性的关键一步。 此外,随着技术的迭代和攻击手法的不断演进,MCP的安全设计也需持续改进。

例如,结合区块链技术实现工具身份和版本的去中心化认证,能进一步提升不可篡改性的保障。借助人工智能自身的威胁检测能力,MCP系统能够实时洞察异常调用行为,迅速响应潜在的攻击风险。构建完善的工具行为审计体系,也是未来保障工具供应链安全的重要方向。 总体来看,面对日益严峻的工具抢占和山寨攻击风险,Model Context Protocol的安全增强不仅是技术升级的需要,更是维护人工智能应用生态稳定发展的基石。通过引入ETDI、OAuth强化和策略型访问控制等创新技术手段,MCP生态正朝着更安全、更可信赖、更具可控性的方向稳步前行。未来,借助跨界协作和自主创新,将进一步完善安全防护体系,推动人工智能工具化发展迈入新时代。

。