随着人工智能技术的飞速发展,其在数学领域中的应用也日益深入,特别是在国际数学奥林匹克(IMO)这样高水平、注重创造性与深度思维的比赛中,AI的尝试不仅引发了广泛关注,也带来了诸多值得思考的问题。2025年IMO成为人工智能再次冲击人类数学极限的一个重要节点,围绕AI参与者的表现、评估方式以及如何与数学共同体价值观相结合,展开了激烈且必要的讨论。 人工智能尝试解决IMO问题的核心意义在于测试机器在面对高难度数学问题时的推理能力和知识整合水平。与去年相比,今年的AI尝试虽然尚未完全公开个别题目的详细解答,但学界和数学界关键人物纷纷发表看法,指出对这些尝试的评估应更加严谨,尤其是在评判标准、计算资源使用透明度以及成果的证明方式上需要明确规范。著名数学家以及研究者们强调,只有建立科学合理的评估体系,才能真正理解AI在解决复杂数学问题时的潜力和局限性。 在评估AI解题表现时,扩展性问题成为核心议题之一。

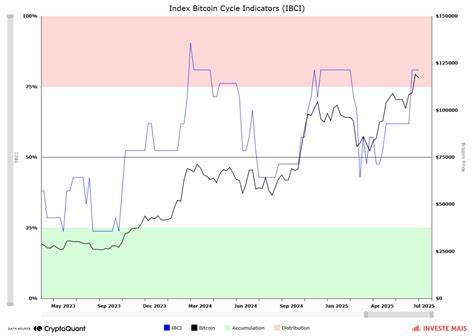

具体来说,学界关注AI在处理更具挑战性的问题时,时间和资源的消耗是否呈线性增长,还是会出现指数级的复杂度提升。两类扩展性问题值得重视:一种是空间扩展,指当问题难度翻倍时,AI所需时间是否也相应翻倍还是更多;另一种是时间扩展,即随着算法和技术的进步,AI是否能够对更深层次、更复杂的问题展现出更明显的加速效果。有关专家认为,这两种扩展性的研究对于预测未来AI在更高层次数学研究中的适用性和有效性具有重要意义。 另一方面,AI目前多采用非形式化的文本输入输出方式参与IMO题目的解答,这在某种程度上限制了对结果的严格验证。数学界长期以来推崇基于形式证明系统的严谨方法,认为只有通过正式逻辑系统生成和验证的证明,才能真正确保结果的正确性。因而,未来AI的挑战方向应逐渐向形式化证明转型,使计算机不仅给出答案,而且给出可被验证的严谨证明,从而提升数学证明的可信度和安全性。

这不仅有助于防止潜在的错误,而且有助于未来解决极为复杂甚至千页级别的数学难题时,减少人工核查的负担。 值得关注的是,AI在数学研究领域的应用带来了文化层面的冲击。IMO作为一个本质上属于人类的竞赛活动,代表着独特的数学文化和价值体系。人类参赛者的努力、创造力和交流互助一直是这一社区的核心。AI的介入如果不尊重这一文化,过于强调自身的展示效果和商业价值,可能被视为对数学社区的一种“文化挪用”。且今年甚至出现了未经授权的大规模爬取IMO竞赛系统数据的行为,严重影响了竞赛的正常运行,这进一步加剧了社区对AI企业态度的担忧。

此外,数学界普遍强调透明和开放的重要性。相比于大多数商业AI开发团队秘密进行模型训练和优化,IMO社区拥有长久以来的协作与共享传统。开放源码的AI模型不仅能够促进更广泛的合作,也更符合数学共同体的价值观。今年,IMO相关组织提出,应要求参与AI挑战的模型公开发布源代码,以促进技术共享和进步,而不是封闭开发、独自占有。 另一个亟需解决的问题是AI生成内容的质量控制。深度学习模型可能会产生看似合理但存在逻辑漏洞的“证明”,甚至某些系统曾因漏洞利用而提交错误形式证明。

在形式证明环境中,这些问题可以依赖健壮的验证内核进行检测和阻断,但非形式的自然语言推理则难以设立同样的严格把关机制。因此,对于AI提供的解答,数学家们呼吁采用严格的机械化证明辅助系统以降低错误风险,防止错误传播。 未来,随着计算能力的提升和算法的改进,AI在解决数学难题上的表现有望取得突破。然而,这一进展应建立在既尊重竞赛本身规则和精神,也尊重数学公共文化传统的基础上。合理的发布时机、透明的信息公开和合作共享是促进AI与数学社区和谐共存的关键。 总体而言,2025年的国际数学奥林匹克AI尝试不仅是一次技术测试,更是一场不同文化价值观之间的撞击和融合。

数学界对AI的态度体现出既期待又谨慎,既赞赏其潜在能力,也提醒警惕其可能带来的挑战。未来AI在数学竞赛和研究中的角色,必将随着技术、伦理和社会规范的不断演进而发展,期待数学与人工智能能够协力开创更加辉煌的科学未来。