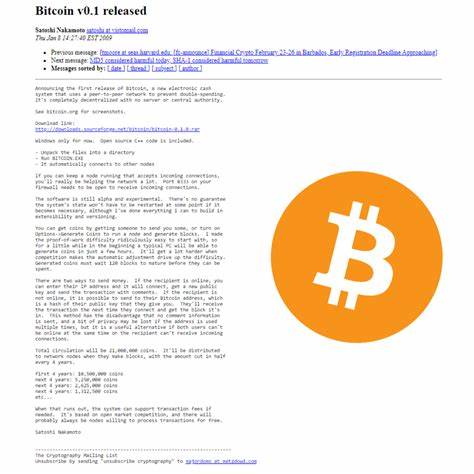

随着人工智能的快速发展,尤其是大型语言模型(LLM)的广泛应用,如何高效、安全、便捷地分发和运行这些庞大的模型权重,成为业界关注的焦点。Llamafile作为一项突破性技术创新,实现了将大型语言模型权重转化为可执行文件的功能,极大地简化了模型的部署与使用流程,正逐步引领AI分发进入新的时代。Llamafile最初由Mozilla创新团队主导开发,得到了Justine Tunney——著名的Cosmopolitan Libc项目创始人的鼎力支持和协作,二者优势互补,共同解决了多平台跨架构运行中的诸多技术难题。传统上,大型语言模型如GPT等通常以静态文件的形式存在,文件体积庞大,格式复杂,且在不同操作系统和硬件架构之间的兼容性问题频发。开发者和用户在使用时往往需要经过繁琐的安装、配置甚至二次转换过程,阻碍了模型的高效推广和实际落地。Llamafile的诞生正是为了打破这些桎梏。

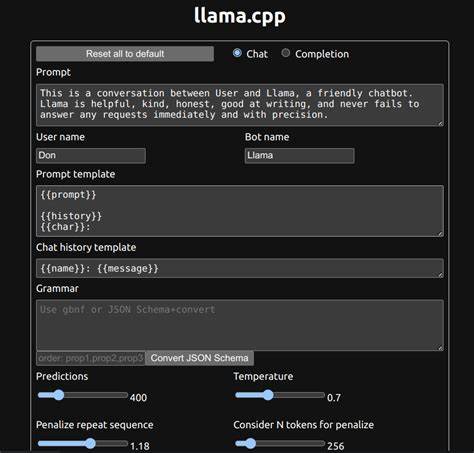

通过将模型权重直接编译为跨六大主流操作系统(如Windows、macOS、Linux等)均可运行的二进制可执行文件,Llamafile不仅简化了部署流程,还确保了模型运行的一致性和可重现性。换言之,用户无需关心环境配置,只需直接运行即可立刻调用模型,极大降低了使用门槛。实现这一目标,Llamafile融合了llama.cpp框架和Cosmopolitan Libc的核心技术。llama.cpp作为业界领先的开源LLM聊天机器人框架,以其轻量级、高效的特性受到了广泛赞誉。Cosmopolitan Libc则是一款支持跨平台跨架构C程序编译和执行的革新型库,使得在不同系统间能够无缝运行同一程序成为可能。两者结合,不仅实现了高效的模型推理能力,还解决了跨平台兼容的根本问题。

在技术实现方面,Llamafile团队深入解决了诸如GPU支持、动态库加载(dlopen())等复杂挑战,从而提升了对硬件资源的调用效率和运行时的灵活性。尤其是在GPU环境的调优,使得Llamafile的执行效率远超传统方式,满足了AI应用对速度和稳定性的极高要求。而从开源社区的角度来看,Llamafile同样展示了强大的生命力。该项目采用Apache 2.0许可证发布,鼓励全球开发者积极参与贡献,推动项目快速迭代和生态丰富。同时对llama.cpp框架的改动保持MIT许可证兼容,有效促进了上游项目的融合和协作,彰显了开源精神的包容和创新。对于企业和研究机构而言,Llamafile提供了极具吸引力的价值主张。

通过将模型权重独立打包为可执行文件,可极大降低对部署环境的依赖,简化运维难度,且提升模型的安全性和版权保护能力。此外,Llamafile所带来的可持续性特征意味着,一套被编译好的执行文件可以保证在未来技术变迁中依然保持可用,有助于避免因格式更迭导致的资源流失和重复工作。随着AI技术日益普及,模型权重规模激增,如何解决模型分发的瓶颈问题成为重要课题。Llamafile的创新模式为业界提供了一个全新思路,不仅提升了模型的可用性和用户体验,也推动了人工智能基础设施的优化升级。未来,随着更多开发者和企业加入这一生态,Llamafile势必会持续完善,带来更多令人期待的变革。综合来看,Llamafile这一开源项目的推出,是对现有AI模型部署方式的一次革命性升级。

它以技术创新为驱动,兼顾多平台兼容性和持久可用性,着眼于推动开放共享和生态建设,激发了更广泛的社区活力。对于想要快速、高效利用大型语言模型的开发者和机构来说,Llamafile无疑是值得关注和探索的重要工具。未来,随着更多功能的完善与应用场景的拓展,Llamafile有望在提升AI应用普及率、推动跨界融合和实现技术民主化方面发挥不可替代的作用。掌握Llamafile,也就掌握了未来AI模型分发的核心脉搏。