近年来,随着深度学习技术的飞速发展,神经网络已经成为处理复杂数据和任务的核心工具。尤其是在视觉、自然语言处理和生成模型领域,神经网络以其卓越的表达能力和学习潜力,广泛应用于各类实际场景。然而,理解神经模型内部的机制与动态,仍是机器学习领域极具挑战性且备受关注的前沿问题。传统上,神经网络被视作复杂的函数映射,将输入转换为期望的输出,但这种黑箱式理解往往难以揭示其内在动力学特征。近期,研究者逐渐将目光转向潜在空间,即神经网络内部对数据进行低维编码的隐空间,试图通过分析潜在空间的结构和动态行为,获得对模型工作机理的更深刻理解。潜在空间不仅反映了数据的几何形态,还承载了神经网络学习到的知识和规律。

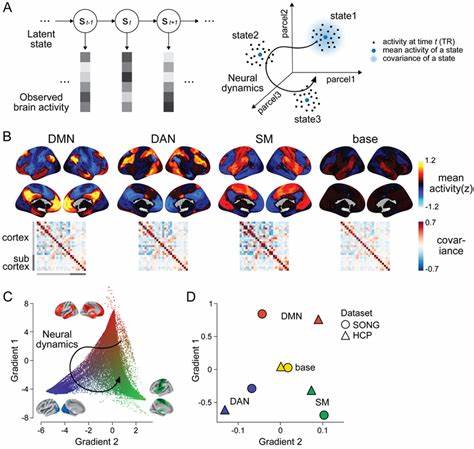

本文将聚焦于神经网络潜在空间动态的剖析,特别是自动编码器模型中潜在向量场的生成与演化机制,探讨如何将神经模型视为潜在流形上的动力系统,并揭示训练过程中引入的归纳偏置如何催生吸引子,这一发现不仅丰富了理论视角,也为分析模型泛化能力、记忆机制以及异常检测提供了新工具。自动编码器作为神经网络的典范结构,通过编码器将输入数据映射到潜在空间,再通过解码器重建原始输入。该过程看似简单,却在潜在空间中暗藏丰富动态过程。最新研究表明,迭代应用编码-解码操作可视为定义在潜在流形上的一个向量场,即潜在空间中的点在不断经过映射后呈现规律性流动,这种向量场反映了网络如何在潜在空间中"导航"数据表示。更重要的是,标准的训练方法自然带来某些结构性的变化,形成了吸引点,这些吸引点代表潜在空间中的稳定状态,对应于网络对某些数据模式或特征的记忆和提取。吸引点不仅揭示了模型如何在潜在空间内定位典型数据,还为分析模型在泛化与过拟合之间的表现提供了关键指标。

吸引子的存在使得模型在面对未知或异常样本时,其在潜在空间中的轨迹将偏离这些稳定点,从而展现出异常行为。这为异常检测和分布外样本识别开辟了一条新的方法路径。通过追踪潜在空间中样本的演化轨迹,可以有效辨别模型是否遇到了超出训练分布的新样本,极大提升模型在实际应用中的鲁棒性和安全性。此外,基于向量场的潜在空间动态分析,有助于提取和理解模型参数隐含的先验知识。这种方法无需依赖输入数据,通过解析潜在空间的动力结构,科学家能够揭示训练过程中模型自发形成的知识模式,为模型设计和调优提供理论依据。在计算机视觉领域,此类研究具有重要现实意义。

视觉基础模型往往处理高维图像数据,通过潜在表示实现语义压缩和结构化表达,然而如何洞察模型内部的动态变化却长期缺乏有效手段。通过建立潜在向量场的动力系统视角,研究者成功揭示了视觉模型在潜在空间的流水线式演化轨迹,帮助分析模型对图像类别、风格与细节的不同泛化能力,为推动视觉模型性能优化提供了理论支撑。总的来看,将神经模型视为潜在流形上的动力系统,不仅从全新视角诠释了深度学习模型的内在工作机制,也促进了机器学习理论的发展和实践应用的创新。从泛化机制的深度剖析、记忆与模式形成的动力揭示,到在异常检测和模型安全领域的应用,这一研究方向无疑将为未来神经模型设计和分析奠定坚实基础。随着相关理论和算法的不断完善,潜在空间动力学的研究将激发更多跨学科的创新,推动神经网络向更加透明、高效和安全的方向发展。 。