在人工智能和机器人技术飞速发展的今天,如何让机器人更好地适应不断变化的环境,成为了研究的焦点。传统的机器人系统往往在单一且相对稳定的环境中表现出色,但一旦环境因素发生变化,机器人往往难以快速调整策略,导致性能大幅下降。现实世界中的变化充满不确定性和复杂性,从表面看似相同的物体可能因为材质、摩擦力甚至环境温度的不同,表现出截然不同的物理特征。机器人如果不能及时感知并适应这些变化,就难以完成预期任务。面对这一挑战,近期对“分类器无指导”策略的研究为机器人自适应能力的提升提供了新的思路。分类器无指导(Classifier-Free Guidance,简称CFG)最初在生成模型中用于提高样本质量和多样性,而其被应用于控制策略优化后,展示出了对机器人适应环境变化的潜力。

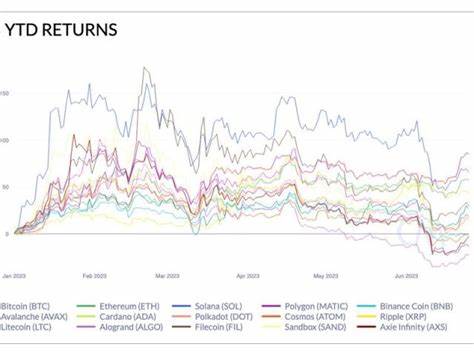

基本思想是通过调整策略的自由度和目标函数的引导强度,在追求任务目标的同时,保留一定的灵活性,允许机器人在面对新环境时尝试偏离以往经验,从而学习新的环境特征及其对动作结果的影响。传统的策略迭代方法往往通过强化学习或者生成模型实现,高强度的指导参数(γ>1)会让机器人策略快速收敛在某一任务表现优秀的策略上。这种方法保证了机器人在已知环境中表现优异,但缺乏应对环境变化的弹性。相反,当将指导参数调节到介于零到一的区间(0<γ<1)时,机器人在任务执行中会出现一定的“犹豫”和“探索”,不完全依赖已有世界模型,具有更高的环境塑性。塑性意味着机器人更容易感知环境的反馈变化,并通过调整行为来适应新的环境条件。塑性与赋权(empowerment)可以看作是一对镜像概念:赋权代表机器人能够控制环境中的未来状态,强化自身目标实现的能力;而塑性代表机器人受环境影响、学习环境特性的能力。

高赋权通常伴随着低塑性,这种权衡决定了机器人在专注任务执行和持续学习适应之间的平衡。以机器人抓取物品为例,若机器人训练时接触的物品摩擦力稳定,那么机器人策略会快速收敛于高效的抓取动作。这时机器人赋权很强,但塑性较低。当机器人面对摩擦力大幅变化的物品时,如果赋权依然保持强势,机器人抓取成功率将下降,因为它未能真正理解摩擦变化对行为结果的影响。提高塑性,机器人即可根据摩擦变化调整抓取策略,提升适应性。这种思路挑战了传统“仅优化任务表现”的训练范式,强调让机器人不断适应环节,引入动态的世界模型,不断更新对环境的认知。

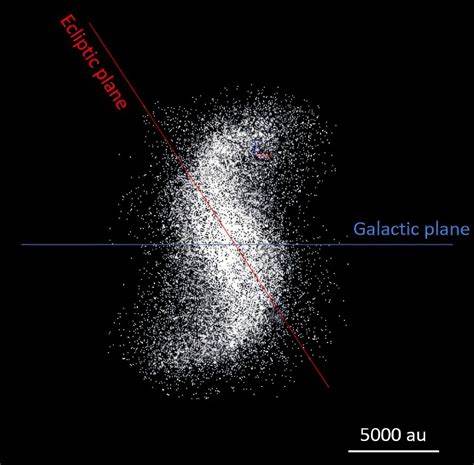

换言之,机器人不再是死板执行程序,而是在执行中学习,持续调整,甚至预见环境变化对任务的潜在影响。近年来关于机器人和一般智能体需要具备世界模型的研究进一步印证了这一点。一个优秀的策略不仅仅是完成某个任务,更代表了对环境动力学的准确建模。改进策略本质上是提升世界模型的准确度,而更准确的世界模型反过来促进策略优化。特别是在包含多个子目标的复杂任务中,这种双向提升尤为重要。通过分类器无指导调整参数,开发者有机会在测试阶段动态调节机器人的策略自由度,实现实时的适应能力调节,而无需重新训练。

这种“训练时固定、测试时灵活”的设计有望大幅降低机器人部署成本,同时提高在异构环境中的鲁棒性。未来,结合持续强化学习(Continual Reinforcement Learning)框架,利用CFG参数调控机器人行为的“偏差后悔值”(deviation regret),机器人可以在不断变化环境中自我校准和决策优化,表现出类人般的适应智慧。这一方向不仅提升机器人在工业制造、物流运输中的应用效率,也极大拓宽了机器人进入日常生活服务领域的可能性,不论是家务助理,还是灾害救援机器人,都需要这种高度的适应能力。归根结底,适应环境变化的机器人代表了人工智能发展的一个重要阶段——从静态任务执行者向动态环境学习者转变。围绕分类器无指导策略的探索为实现这一转变提供了一条明确路线。未来研究应继续深挖赋权与塑性的平衡机制,发展更丰富的环境感知模型和自适应策略设计,让机器人更从容应对世界的多变与不确定。

只有如此,机器人才能真正走出实验室,迈向智能化、灵活多变的真实世界应用场景。