在如今复杂的云原生和分布式系统架构中,工程团队越来越依赖多个监控和告警工具来保障系统的稳定运行。Datadog、PagerDuty、GitHub以及Kubernetes等工具成为主流,每种工具专注于不同层面的监控和管理。然而,复杂服务和多层依赖意味着告警往往跨越多个工具,导致排查流程繁琐且易陷入循环。本文将结合工程实践,剖析团队如何高效排查跨工具告警,优化响应流程,提高事件处理速度和准确性。 当接到一个跨多个监控平台的告警时,如何快速定位问题是关键。在事件刚发生的前几分钟,经验丰富的工程师通常会打开几个关键界面和命令行工具,如Datadog的监控面板查看系统指标变化,PagerDuty定位具体告警内容和影响范围,GitHub审查近期提交和变更记录,同时使用kubectl或者其他Kubernetes命令行工具检查集群状态。

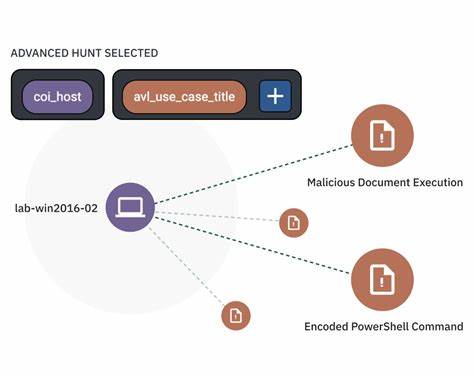

通过这些渠道,工程师能够初步判断问题的性质,是代码引发故障、基础设施瓶颈还是外部依赖变更导致系统异常。 在跨工具告警中,从监控波动到代码变更的转移尤为关键。团队通常会通过Datadog监控到指标的异常波动,比如某个服务响应时间暴增或错误率攀升后,随即启动事件调查流程。紧接着,他们会切换到版本控制系统核对最近的pull request和代码提交,寻找可能的逻辑缺陷或者配置更新。如果团队配备自动化工具,可以利用告警关联和事件上下文的智能关联功能,将监控数据、代码提交和变更日志联系起来,加速分析效率。自动化工具的引入能够节省时间,尤其是在紧张的凌晨或紧急场景中,减少人工逐条排查的负担。

调查过程中,团队常常在某些环节卡顿,主要原因是信息割裂与沟通成本高。告警从一个系统跳转至另一个系统,数据和日志的格式不统一,查询语法和操作界面也不同,使得工程师往返切换时效率低下。尤其是当跨部门协作时,责任划分不清晰和缺少统一协作平台容易导致重复调查、信息丢失或遗漏隐患。对此,许多团队开始探索整合告警和事件管理平台,打造统一的响应中心,确保所有相关信息集中呈现,降低事件管理碎片化的风险。 在实际工作中,某些小技巧能显著加快排查节奏。一些团队会预设“快速启动模版”,在告警发生的第一时间就打开固定的一组监控视图和命令行窗口,确保关键指标和系统日志触手可及。

另有团队开发专属查询脚本,批量提取相关日志信息,快速锁定异常点。此外,团队会养成及时记录排查过程和步骤的习惯,保证事件流转透明且后续可复盘,避免重复劳动。 对于可以委派的工作,有些团队愿意将重复性高且低风险的初步数据收集环节交给新手或者自动化系统。例如,由自动化脚本定时统计告警指标趋势和系统状态概览,将结果汇总报告给一线支持人员或者实习生,由他们完成基础排查和文档整理,再由经验丰富的工程师深入分析根因。这样不仅能够释放资深工程师的时间,也快速提升整个团队的响应效率和质量。 结合实际2点凌晨的紧急情况也是宝贵的经验。

由于无人多团队成员需保持极高的警觉性,自动化工具和流程极为重要。当团队尝试过单纯人工切换工具排查、手动比对数据时常常耗时过长甚至遗漏关键线索。后续引入集成化监控面板和自动化事件通知,极大提升了故障反应速度和准确度,有效缩短了平均事件解决时间。 面对多工具告警排查的挑战,建设统一的事件管理平台、完善自动化工具链、优化告警策略和持续培训团队成员,成为提升整体运维水平的关键。通过系统化方法,工程团队不仅能缩短响应时间,还能积累宝贵经验和优良实践,更加从容地面对复杂多变的生产环境。未来,随着技术发展和工具融合,多工具协同告警排查将日益高效,推动业务稳定和创新持续奔跑。

综上所述,跨工具告警排查虽有诸多挑战,但通过科学的流程设计、自动化辅助和团队协作优化,完全可以实现高效稳定。每一个现代工程团队都应结合自身业务特色,持续完善事件响应策略,确保在关键时刻能够快速准确反应,保障服务的高可用性和客户体验。