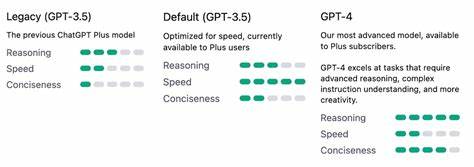

随着人工智能技术的快速发展,大型语言模型(LLM)已成为推动自然语言处理领域革命性进步的重要力量。GPT-4等先进模型以其强大性能,改变了机器理解与生成语言的方式,广泛应用于问答系统、自动写作、翻译、代码生成等诸多领域。然而,体积庞大、计算需求高昂的顶级模型也带来了相应的资源消耗和使用成本,限制了其在更多实际场景中的推广与应用。近期,一项名为"弱Bandit反馈下的大型语言模型路由"(Adaptive LLM Routing under Budget Constraints)的研究引起了业界关注,提出了一种创新的模型选择与路由机制,能够在保证约93% GPT-4性能的同时,将成本降低至仅为四分之一,极大提升了人工智能技术的成本效益比。大型语言模型路由技术的发展背景多样且复杂。面对不同类型的用户查询及任务,单一模型往往无法兼顾效率、准确性和成本。

传统做法多集中于固定使用GPT-4或其他顶级模型,或人为设定层级调用顺序,这导致资源浪费或性能缺失。理想的策略是针对每个具体请求动态选择最适合的模型,权衡性能与成本,达到智能分配算力的目的。早期研究大多把模型选择视为监督学习问题,需事先拥有一组完整且准确的查询-模型匹配标签。然而在实际应用中,查询类型千变万化,且实际最优匹配信息难以获取,传统监督方法难以应对环境动态变化及多样化需求。针对这一挑战,研究团队提出将LLM路由问题视为一种"上下文Bandit"(contextual bandit)问题,利用在线弱反馈信号进行学习和调整。上下文Bandit是一种强化学习场景,代理在每轮决策时根据上下文挑选动作,通过有限反馈调整策略,适合解决查询与模型匹配中的探索与利用冲突。

该研究设计了共享的嵌入空间,统一表示用户查询与多种LLM,使得二者之间的相似性能够量化,形成有效匹配基础。嵌入空间的初步构建基于离线收集的人类偏好数据,这一步骤保证路由机制具备较为合理的先验知识。其后,系统通过在线Bandit反馈不断调整该嵌入空间,强化对用户实际需求的感知和响应能力,确保模型选用策略适应环境变化。核心算法PILOT(Preference-prior Informed LinUCB for adaptive routing)创新地将LinUCB方法扩展用于多模型路由任务。LinUCB是一种广泛应用于上下文Bandit的有效算法,擅长在有限反馈环境中提升动作选择质量。PILOT结合偏好先验信息,增强在高维嵌入空间中的决策效果,实现了快速且精准的模型路由选择。

考虑到实际部署时用户预算多样,资源有限,研究中引入了在线成本策略,建模为一个多项选择背包问题,该策略能在保证整体预算约束下,为不同查询分配最优模型。适度降低精度以换取成本优势是实际应用中常见的权衡,本文方案通过合理设计和算法优化,成功实现性能与成本的平衡,表现出接近GPT-4的绝佳执行效果,但总体成本却显著降低,约仅为使用完整GPT-4模型的四分之一。这项技术的商业和社会价值极为显著。对于企业来说,可以极大减轻人工智能计算资源压力,显著降低运维和使用成本。对于研究机构而言,提升更多研究和开发的可行性,为更多创新应用提供坚实技术支撑。同时,对于用户体验也带来了明显提升:响应更快、费用更低,同时保持了高质量和准确性的交互体验。

未来,弱Bandit反馈下的LLM路由方法有望结合更多模型类型,支持更个性化和多样化的自然语言处理任务。这种自适应的模型选择机制也可拓展至语音识别、图像生成、推荐系统等多领域的智能算法分配,促进人工智能整体生态的智慧升级。随着算法进一步完善和计算能力的提升,成本与性能的矛盾将被逐步缓解。总的来看,弱Bandit反馈驱动的智能大型语言模型路由技术为当前和未来的自然语言处理应用带来了全新解决路径,可实现性能接近顶级模型而成本大幅降低的重要突破,使先进AI技术能够更加普惠、更广泛地应用于各类实际场景。业界和学术界对此类创新解决方案给予高度关注,期待它们在现实中进一步验证和推广,推动人工智能技术向更加高效、经济和智能的方向迈进。 。