测量误差模型是统计建模和贝叶斯分析中常见的技术,尤其在经济学、社会科学和公共卫生等领域中广泛应用。Andrew Gelman提出的一种经典测量误差模型,以其简洁明了的结构和实际适用性,成为教学和研究中的重要示例。然而,传统方法使用Stan软件实现时,往往面临采样效率低下、收敛速度缓慢的问题,影响模型推断的实用价值。2025年,随着大语言模型(LLM)技术的飞速发展,尤其是ChatGPT 5在数学推理和编程能力上的突破,贝叶斯建模迎来了前所未有的变革机遇。本文将聚焦ChatGPT 5如何辅助实现Gelman测量误差模型的边缘化操作,并在Stan中优化采样表现,推动统计学软件智能化应用的进步。Gelman测量误差模型简述测量误差模型旨在应对观测变量中存在误差的情况。

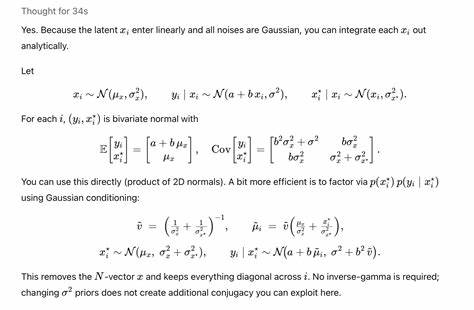

Gelman的经典模型通过隐变量x的正态分布假设,连接真实变量与含噪声的观测变量x_star及响应变量y。模型核心结构包括:x变量先于参数μ_x和σ_x下服从正态分布;响应变量y由线性关系a + b*x加上误差σ正态分布生成;观测值x_star受x及测量误差标准差σ_x_star条件影响。此模型因参数多且涉及隐变量,直接采样往往面临慢收敛及高相关性难题。Stan中实现的挑战及优化尝试由于模型中隐变量x既是参数也是数据的"中间层",传统Stan采样流程往往遭遇"漏斗"效应和慢混合。Gelman及合作者尝试中心参数化但易导致后验收敛缓慢,改成非中心参数化后改进显著。Bob Carpenter等学者进一步引入弱信息先验,并尝试加长采样迭代以提升有效样本容量(ESS),但计算成本极高。

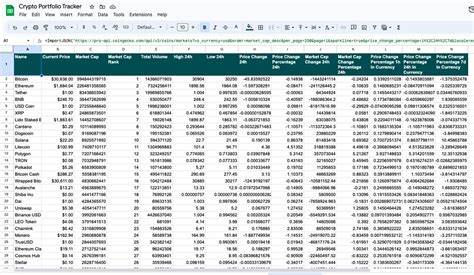

此时,边缘化技术成为突破瓶颈的关键。ChatGPT 5协助边缘化的突破性应用在数学推导与代码生成均存在较大障碍时,大语言模型展现出其卓越的辅助潜力。Bob Carpenter与Andrew Gelman的合作案例中,ChatGPT 5被赋予计算和推导将隐变量x边缘化的任务,基于正态分布复合的性质,成功导出隐变量整合后的条件分布表达并生成优质Stan代码。该边缘化模型以新的参数化形式替代了原有庞大的隐变量空间,显著降低了参数维数。此举直接减少了计算负担,使HMC采样过程更高效,产生更快混合以及更高ESS。边缘化模型的Stan代码中,x不再作为参数直接采样,而通过计算其条件期望和方差与观测x_star关联,由此推导出y的条件分布。

ChatGPT 5不仅自动完成繁琐的代数推导,还在代码风格和实现细节上提供贴合Stan规范的建议,体现了AI辅助统计编程的新趋势。边缘化带来的实质性能提升Bob Carpenter实际在Stan中运行ChatGPT 5生成的边缘化模型,发现采样器第一次运行即实现了数量级提高的效率,估计参数的有效样本量数倍于传统模型的数百次迭代。相比之前需要数千甚至数万迭代的做法,边缘化模型大幅缩短了计算时间,提升了模型的适用韧性。该方法还保留了贝叶斯建模的灵活性和参数解释性,便于后续扩展及应用于更复杂的测量误差体系。边缘化虽有优势,但仍需结合问题特性灵活适用。深入理解正态分布性质及矩阵代数,有助于用户更好地定制适宜的先验,改善模型收敛。

ChatGPT 5的示范与教学意义随着ChatGPT 5的参与,传统数学推导和统计代码编写门槛大幅降低,极大地促进了学术交流与教学效率。Bob Carpenter计划将该案例纳入Stan用户指南的效率调优章节,通过生动案例为广大用户直观呈现边缘化思路及推导过程。该过程不仅展示了LLM在科研中的直接助力,也澄清了传统人机合作模式的未来前景。用户可通过交互式环境快速尝试边缘化写法,验证理论推导,提升教学质量和研究质量。更进一步,结合高效采样器如Nutpie和WALNUTS,统计模型的智能适配时代已然来临。未来展望:智能辅助统计建模的时代迹象ChatGPT 5边缘化边缘化测量误差模型的实践,标志着统计软件智能化和AI辅助科研的新时代。

基于对模型结构和概率分布特性的深度理解,LLM不仅可以协助生成正确且高效代码,还能激发建模者发现潜在改进路径。此案例的成功激励研究者关注如何在更复杂的层次模型、时间序列、非正态误差模型等场景中实现自动边缘化和重参数化。与此同时,社区内针对模型收敛诊断、采样质量度量的自动化工具研发也步入快车道,LLM或许能在自动判定、迭代改进和方案生成中发挥核心作用。虽然边缘化方法降低了计算量,但也可能限制参数表达的灵活性,因而更完善的智能算法应致力于在自动边缘化和显式隐变量表达间权衡,满足不同研究需求。总的来说,ChatGPT 5辅助Gelman测量误差模型边缘化的成功,是统计建模与AI技术结合的缩影。它不仅让贝叶斯推断变得更快更可靠,也刷新了科研人员解决复杂概率建模难题的想象边界。

随着LLM模型能力不断提升,未来模型设计、编码、诊断与发布将变得更加自动化、高效与智能,推动科学创新进入全新阶段。 。