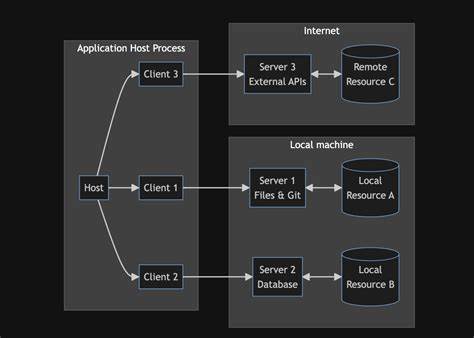

近年来,生成式人工智能技术取得了飞跃式的发展,尤其是大型语言模型(LLM)的广泛应用,极大地推动了智能对话、自动代码生成、文本分析等众多领域的创新。为简化不同AI组件间的集成流程,业界提出了模型上下文协议(Model Context Protocol,简称MCP),该协议旨在统一API接口规范,从而实现语言模型、数据源、辅助工具等多种资源的无缝联动。MCP的引入为构建复杂的自动化工作流提供了极大的便利,令各种AI驱动的应用得以高速发展。然而,随着MCP应用场景的快速扩展,安全风险也日趋显现,部分漏洞甚至可能被攻击者利用,导致系统被远程控制、敏感信息泄露乃至恶意代码执行等严重后果。本文将聚焦于MCP带来的安全挑战,结合最新研究成果详细剖析其潜在威胁,帮助开发人员和安全专家全面理解风险本质,并探讨有效的防护方案。模型上下文协议作为一个开放性标准,通过定义统一的请求和响应格式,使得不同的MCP服务器能够互联互通,每个服务器配备特定工具、数据及提示模板,共同构建一个由LLM主导的自动化执行环境。

这种设计从根本上提升了AI系统的灵活性和扩展能力,用户无需动手编写大量接口代码即可实现跨模型和跨工具的协同工作。然而,正是这种高度动态和复杂的集成机制,为安全隐患的产生提供了温床。安全研究人员通过深入分析MCP的架构发现,当前协议设计存在多种攻击面,其中包括利用协议工具调用权限执行恶意脚本、通过上下文注入诱使模型泄露凭证信息、以及绕过访问控制机制获取未授权资源等。一旦攻击成功,入侵者便能对开发者的系统环境施加控制,造成数据篡改甚至全网瘫痪等灾难性后果。其中,恶意代码执行尤为令人担忧。由于MCP允许模型调用外部工具和服务,攻击者可以诱导模型执行未经严格验证的命令,导致系统运行恶意软件或窃取高度敏感的用户数据。

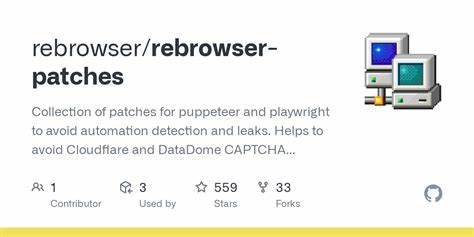

此外,凭证盗窃攻击通过伪装成合法请求,诱使模型返回私钥或令牌信息,严重威胁系统的身份认证和访问安全。为应对这些严峻的安全挑战,研究团队推出了专门针对MCP漏洞的审计工具——MCPSafetyScanner。该工具基于多智能体协作机制,自动化生成潜在对抗样本,模拟攻击过程,识别并分类协议服务器中存在的安全弱点。它还具备搜集漏洞补救措施的功能,能够生成详细的安全分析报告,辅助开发者提前发现并修复风险点,从而提高MCP整体部署的安全性。MCPSafetyScanner开创了利用智能体对抗技术自适应安全审计的新范式,为未来AI系统安全防护探索了高效路径。在实际应用中,除依赖工具自动化审查外,构建健全安全生态同样重要。

首先,开发团队应严格限制MCP访问权限,坚持最小权限原则,避免工具调用滥用。其次,强化输入输出内容的验证逻辑,防止注入攻击。再次,持续监控运行时行为,及时识别异常指令和数据流。最后,培养专业安全人才,促进开发者与安全专家的紧密合作,提升对新型攻击手段的预警和响应能力。伴随着人工智能技术的不断迭代,生成式模型和其接口协议的安全保障成为保障用户权益和技术可持续发展的关键环节。MCP协议作为链接多种智能工具的桥梁,其安全性能直接影响整个AI生态系的稳健性。

通过深入理解其潜在的安全漏洞及攻击方式,结合先进的自动化审计工具和严密的安全管控措施,行业可以有效防范恶意入侵,保障数据隐私,促进AI技术的健康发展。总结而言,模型上下文协议虽然赋予大型语言模型跨域协作的强大能力并推动了智能自动化升级,但伴随而来的安全风险不容忽视。MCPSafetyScanner作为开创性的安全审计工具,为开发者提供了科学、系统的风险检测方法。面对未来更为复杂多变的攻击态势,只有不断完善协议设计、强化防护体系,才能筑牢AI应用的安全防线,保障人工智能技术惠及社会的广泛与持久。