机器学习技术近年来发展迅速,广泛应用于金融、医疗、自动驾驶、推荐系统等多个领域。然而,复杂模型如深度神经网络和集成树模型往往被视为“黑箱”,其决策过程难以理解和解释。模型的可解释性问题不仅影响用户对结果的信任,还可能限制了模型在敏感或监管严格行业的应用。为解决这一瓶颈,快速、可扩展且交互式的机器学习模型可解释性解决方案应运而生,成为连接数据科学与业务决策的重要桥梁。可解释性工具通过揭示模型内部机制,让用户深入了解特征对模型预测的贡献以及模型的整体行为模式,从而提升模型透明度和可控性。传统的可解释性方法如局部可解释模型-agnostic解释(LIME)和SHAP值等,虽然在理论上为模型解释提供了有效手段,但随着数据规模和模型复杂度的不断增长,其计算消耗和响应速度成为制约因素。

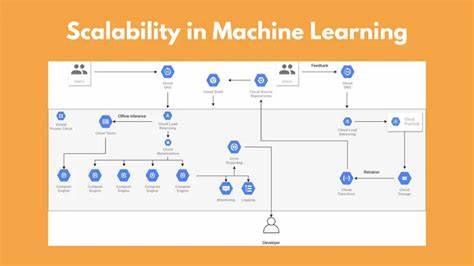

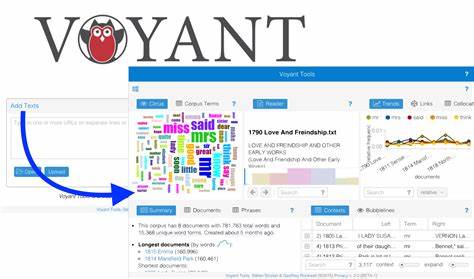

快速且可扩展的可解释性工具致力于优化算法性能,提升计算效率,支持大规模数据和复杂模型的实时解释。同时,交互式设计理念贯穿整个产品,通过直观的可视化界面和灵活的交互操作,帮助用户更好地理解模型预测的细节和潜在风险。快速、可扩展且交互式的模型解释系统结合现代分布式计算架构和云计算技术,实现了弹性扩展和高并发处理能力,使得解释结果可在极短时间内反馈给终端用户。在实际应用中,这类工具支持多模型、多任务以及多用户协同工作,极大提升了团队的协作效率及数据驱动决策的准确性。交互式界面设计不仅允许用户对解释结果进行动态筛选、对比和分析,还支持导入外部业务规则与专家知识,从而实现模型解释的定制化和业务化应用。这种人机协同的方式,促进了模型开发者与业务专家之间的有效沟通,加速了模型迭代和优化过程。

在金融行业,快速可解释性工具帮助金融机构分析信用评分模型的决策依据,确保模型符合监管要求并避免潜在的歧视风险。在医疗领域,可解释模型助力医生理解诊断系统的预测逻辑,提高诊断准确率和医疗服务质量。此外,在自动驾驶和智能制造领域,这类工具增强了系统的安全性和可靠性,为关键决策提供了透明性保障。围绕这些需求,业界涌现出多种优秀的开源与商业解决方案,这些平台不仅支持多种主流机器学习框架,还集成了丰富的解释算法和智能可视化组件,极大降低了用户的使用门槛和技术复杂度。未来,随着人工智能技术的不断进步,模型可解释性也将持续发展,融入更多的自适应学习机制和因果推断方法,进一步提升解释的准确性和实用性。同时,结合隐私保护、安全防护等先进技术,确保数据和模型解释过程的安全合规,推动可解释人工智能在各领域的深度应用。

总体来看,快速、可扩展且交互式的机器学习模型可解释性工具不仅解决了传统方法在性能和灵活性上的瓶颈,也促进了人工智能技术的可信化与普惠化。它让更多人能够直观理解复杂模型的工作原理,增强了人工智能系统的透明度和公平性,为决策者提供了坚实的支持基础。随着技术和应用场景的不断丰富,可解释人工智能必将在未来智能社会中发挥更加重要的作用,成为实现智能决策与负责任创新的关键推动力。