近年来,随着人工智能技术的快速发展,基于变换器(Transformer)架构的大规模语言模型展现了卓越的语言理解和生成能力。它们在自然语言处理、问答系统、文本生成等领域产生了深远影响,极大地推动了人工智能应用的边界。然而,变换器背后的核心机制 - - 注意力机制,在处理长文本时面临着显著的计算和内存挑战,成为制约模型扩展的关键瓶颈。标准的注意力机制计算复杂度呈二次增长,这意味着输入文本长度越长,计算资源需求以平方倍数增加,带来了巨大压力。针对这一痛点,低秩注意力(Low-Rank Attention)作为一种创新技术开始引起广泛关注,为解决变换器在大规模输入处理中的效率问题提供了新的思路。传统注意力机制通过构造一个注意力矩阵,展现每个词汇或标记之间的相互关系,该矩阵的规模随着输入序列长度的增加迅速扩大。

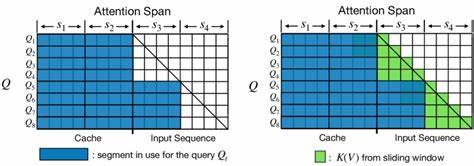

例如,当输入长度达到一千时,模型需要对一百万个词对进行关联计算;当长度翻倍成为两千时,计算量骤增至四百万。因此,这种二次计算复杂度限制了模型在处理超长文本时的可行性,导致计算瓶颈和内存耗尽问题频发。在深度学习和线性代数领域,矩阵的"秩"指的是该矩阵中独立信息的数量,高秩矩阵代表信息复杂且细节丰富,而低秩矩阵则表示存在大量冗余或模式结构,可以用更少的参数近似表达。低秩注意力的核心思想便是利用矩阵的低秩特性,对原本庞大的注意力矩阵进行压缩和近似,以此大幅降低计算量和存储需求。通过将键(Key)和值(Value)矩阵投影到低维空间,模型只需在这较小的维度中执行注意力计算,从而减少了成千上万的词汇间直接比较。这样的压缩不仅提升了处理速度,也极大节省了内存资源,使得长文本甚至超长文本的建模成为可能。

构想一个庞大的摄影图像文件,通过压缩去除非关键细节,获得尺寸更小但仍保持主要内容的版本。低秩注意力就类似于对变换器的注意力矩阵进行"图像压缩",在保证语义表达和上下文关联的前提下,将计算资源消耗降低数倍。除了计算效率的飞跃,低秩注意力还促进了模型的扩展能力。如今的人工智能系统越来越多地尝试处理长篇文章、复杂代码以及多轮对话等多样化场景。传统注意力机制因其计算负担难以应对如此长远的上下文关系,限制了模型的表现。而低秩注意力则助力模型捕获长距离依赖,实现更加连贯和准确的理解与生成。

一个典型的应用案例便是Facebook AI推出的Linformer模型,成功验证了低秩注意力在减少计算成本的同时,基本保持了语言理解任务的性能。Linformer以约1.5倍的速度完成训练,并能在相同硬件资源下处理1.7倍规模的输入,充分展示了该技术实际应用的巨大潜力。与此同时,低秩注意力不仅带来了技术层面的革新,更为人工智能的经济性和环保理念增添了重要动力。随着模型变得越来越庞大,计算能源消耗及碳足迹逐渐成为社会关注的焦点。低秩注意力通过优化计算过程降低能耗,有助于构建绿色AI生态,降低企业部署和维护成本,推动人工智能向可持续方向发展。毋庸置疑,低秩注意力也面临一定的挑战。

由于其本质是对注意力矩阵的近似,模型在极度依赖细节和非线性交互关系的任务中,低秩方法可能会丢失部分关键信息,导致性能下降。此外,如何合理选择秩的大小也是一个需要细心平衡的问题。秩太低虽然节省资源,但可能牺牲模型能力;反之秩过高则削弱了效率优势。这要求研究人员和工程师针对具体场景反复调优和验证。再者,集成低秩注意力进现有变换器模型需考虑软件和硬件的兼容性。从实现角度看,目前社区对标准注意力机制的优化已相当成熟,如高效的GPU计算内核和FlashAttention算法。

相较而言,低秩注意力的相关库和工具尚处于不断完善阶段,这在一定程度上限制了其广泛应用。不过,随着研究深入和技术普及,软件生态的改进指日可待。未来,低秩注意力可能与稀疏注意力等其他高效机制结合,形成混合式高效注意力结构。这种方法能根据输入数据的特点动态选择合适的注意力策略,实现性能和效率的最佳平衡。当前,学术界已经开始探索多样化的低秩模型变体,如基于Nyström方法的注意力近似等,进一步丰盈了该领域的研究景观。低秩注意力的崛起恰逢其时。

随着人工智能模型的持续膨胀,时代呼唤既能保持强大表达力又节省资源的创新技术。硬件性能提升逐渐放缓,碳排放和成本压力日益突出,迫使行业寻求更智能的优化路径。低秩注意力通过根本性降低计算复杂度,助力模型实现长文本高效处理,成为解决规模化制约的一剂良方。综上所述,低秩注意力不仅为克服变换器在长序列建模中的计算瓶颈提供了切实有效的方法论,还为人工智能技术的可持续发展注入了新动力。它通过简化注意力矩阵的内部结构,既保证了模型的上下文关联能力,又显著提升了计算效率。随着研究和应用的深入,低秩注意力势必成为未来大规模语言模型设计的重要组成部分,让人工智能真正做到规模与效率兼得。

广大研发者、工程师及技术决策者应持续关注这一领域的新进展,掌握低秩注意力的原理与实践,以便在日渐激烈的AI竞争中占据有利地位。低秩注意力的成功应用,预示着AI从"一味堆砌算力"向"智慧驱动创新"的转变,代表了人工智能发展的新方向,也昭示了更加高效、绿色且智能的未来。 。