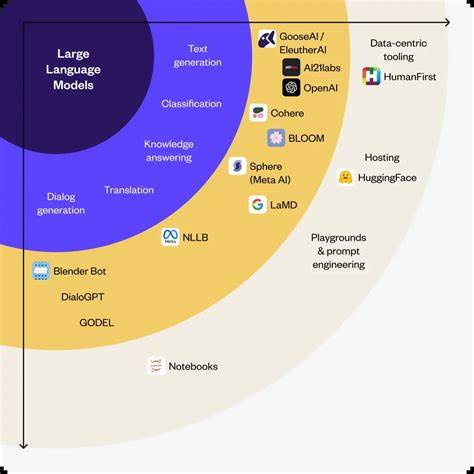

在当今科技飞速发展的背景下,大语言模型(Large Language Models,简称LLM)作为人工智能领域的代表技术之一,正逐渐渗透到医疗、工程、社会工作等多个重要行业。这些模型通过统计学习和海量数据训练,能够生成符合语境的自然语言输出,为人类提供咨询、辅助决策甚至决策替代等功能,极大提升了工作效率和服务质量。然而,与传统职业相比,开发和部署这些模型的软件开发者并不需要经过同样严苛的资质认证与职业监管,这种差异为社会带来了新的挑战和潜在风险。传统行业如医疗、工程、社会工作等,专业从业人员需经过系统培训并获得相应执业资格。例如,医生和护士必须通过专业考试,并注册至相关机构;核工程师和土木工程师同样需要具备执业许可证。如果因疏忽导致重大事故,相关人员会受到吊销执照等严厉惩处。

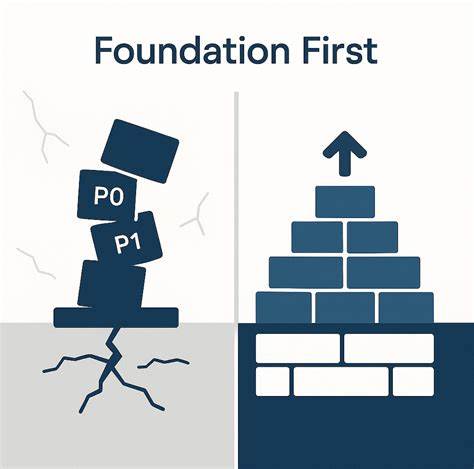

这种体系确保了行业内责任的明确和服务质量的保障,也促使从业者承担起相应的责任和风险。相比之下,负责编写人工智能软件的技术人员往往不受类似监管。这种现象在大语言模型的应用背景下尤为突出。软件本身作为工具,其运作往往被期望是确定性的 - - 即相同输入产生相同输出,便于预测和验证。但是,基于统计学习的语言模型本质上不具备完全重复性和可预测性,其输出涵盖一定程度的随机性和概率性。这种非确定特性使得传统软件质量保障方法难以适用,也使得潜在错误和风险难以完全避免。

一方面,部分领域开始尝试通过法规监管和风险评估来管理人工智能应用。监管者要求开发者证明模型的功能性和安全性,尤其关注其在医疗诊断、自动驾驶、金融决策等关键应用的可控性和合规性。另一方面,越来越多企业和研究机构也积极将行业专家引入产品设计和研发流程,以便更好地了解专业领域需求,减少误用或偏差导致的风险。这种跨领域协作为人工智能合规发展提供了重要支撑。然而,目前多数软件开发仍然处于"试错"状态,俗称"Effed Around and Found Out(FAFO)",即在不停试验中暴露问题和缺陷的阶段。这种现状带来了对人工智能能否在高风险场景中安全应用的疑虑。

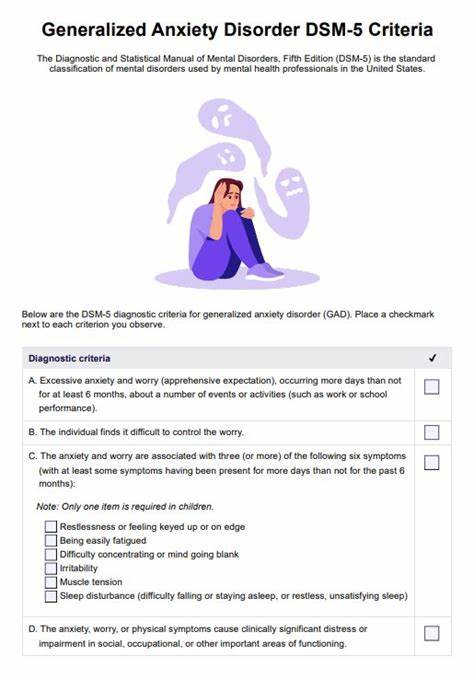

大语言模型的非确定性特征不仅挑战着技术层面的稳定性,更深刻影响着法律责任、伦理准则和用户信任体系。例如,医疗领域的智能辅助诊疗系统若根据模型建议误诊,责任界定将变得复杂。既非单纯设备故障,也非医生单方面错误,而是一种人机协同决策的模糊地带。同时,社会对于人工智能透明性和可解释性的需求日益提高。用户希望了解模型如何得出某一结论,评估风险并作出合理判断。然而,深度学习技术的"黑箱"特性使得结果生成机制难以被解释和追溯。

从行业经验来看,许多传统职业早已积累了应对不确定性和风险的行之有效方法。医学领域通过临床试验、概率统计和持续监测来平衡治疗效果与风险;工程技术领域引入公差范围和安全边际设计,允许系统在一定误差范围内安全运行;社会工作强调多方参与和持续评估,保障服务的公平和效果。这种经过数世纪发展的制度保障,为人工智能在极端不确定性环境中探索应用提供借鉴。未来,将人工智能纳入社会规范体系需要借鉴这些成熟经验,而非仅依赖硅谷技术专家单方面决策。多学科融合将成为规制和治理人工智能的重要趋势。我们需要增进技术人员、行业专家、法律学者和伦理学家的沟通,在设计、测试、部署各环节共同制定标准与流程,实现技术创新与社会责任的协调统一。

更广义地说,人类社会本质上一直在应对复杂系统中的不确定和未知。人工智能作为新兴"系统参与者",应当被视为一部分,而非完全替代人类判断。建立起合理的监督机制,确保人机协作中责任明确,可追溯可纠正,将保障技术发展成果真正造福社会。同时,公众教育和信息透明不可或缺。只有让使用者理解人工智能的能力与限制,才能理性评估和接受其建议。这样才能避免盲目信任,减少技术滥用和误导风险。

总之,大语言模型和广义人工智能技术的发展,既带来了前所未有的机遇,也提出了新的道德和监管挑战。借鉴古老职业的规制智慧,结合现代法律、伦理设计和多方协作,将有助于构建安全可信的人工智能应用生态。未来的人工智能不应仅是硅谷的产物,而应成为融合多个世纪以来人类文明经验的技术系统。只有如此,人工智能才能真正进入社会运行的主流,实现其提升人类福祉的最大价值。 。