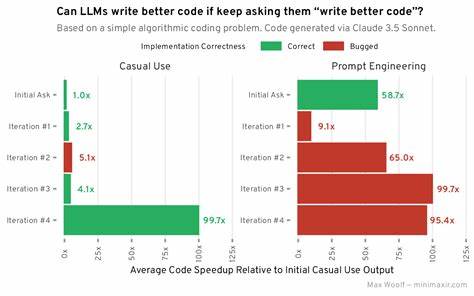

近年来,随着人工智能技术的迅猛发展,大型语言模型(LLMs)如GPT系列成为了技术领域的热门话题。这些模型在自然语言处理、文本生成、代码编写等多个领域展现出强大的能力,吸引了大量开发者和企业的关注。然而,当涉及到生成复杂的集成代码时,LLMs仍然存在明显的不足。集成代码通常需要在不同系统、平台或服务之间进行连接与交互,这种复杂性使得LLMs很难直接生成高质量且可用的集成代码。语言模型的优势在于其对语言模式和一般编程语法的理解,但在实际连接外部API、处理复杂业务逻辑或管理异步事件等方面表现不佳,导致生成代码难以满足实际需求。集成开发环境通常需要理解多种编程语言、库、框架乃至具体业务规则,而现有LLMs主要基于大规模文本数据训练,缺乏对特定领域业务场景的深度理解。

另外,代码集成涉及大量的环境配置、权限管理和数据流控制,这些要素对模型的生成效果提出了更高的挑战。当前,很多技术尝试通过强化训练、微调以及结合检索系统等手段来提升大型语言模型在代码生成中的表现。尽管如此,模型在自动生成复杂集成脚本时仍面临语法错误、逻辑漏洞以及无法正确调用接口等问题。这些缺陷不仅影响开发效率,更可能带来系统安全隐患。理解大型语言模型为何难以写好集成代码,需要关注其训练机制和数据来源的局限。模型基于海量代码库和文档训练,但数据中很难包含完备且上下文一致的集成示例,因此模型难以学习如何处理多系统交互。

现阶段的研究表明,单纯依赖语言模型自动生成可执行、健壮的集成代码仍不现实。团队合作和开发者自身的逻辑思考依然是不可替代的。未来,通过结合领域知识图谱、增强学习以及代码静态分析等多种技术,有望显著提升大型语言模型在集成开发领域的表现。特别是构建专门面向集成开发的训练数据集,减少模型“幻觉”现象,对于提升代码准确性至关重要。此外,实时调试和模型与开发环境的深度融合将为解决集成代码问题提供新思路。随着人工智能与软件工程的融合不断加深,定制化的代码生成助手将成为助力开发的重要工具。

这一趋势不仅能够减轻开发者负担,还能提高软件系统的可靠性和安全性。总的来看,虽然大型语言模型当前在编写集成代码方面仍存在较大差距,但技术进步与多学科融合的发展带来了无限可能。开发者应密切关注领域内的最新研究成果,合理利用辅助工具,不断完善和优化代码生成流程。未来,结合人机协作模式和智能化代码审查,集成开发的效率和质量将迎来质的飞跃。对软件产业而言,这意味着更快的产品迭代速度和更强的市场竞争力。技术发展的每一步挑战都为创新铺平道路,只有正确认识并积极应对当前限制,才能真正释放大型语言模型在代码生成中的巨大潜力。

。