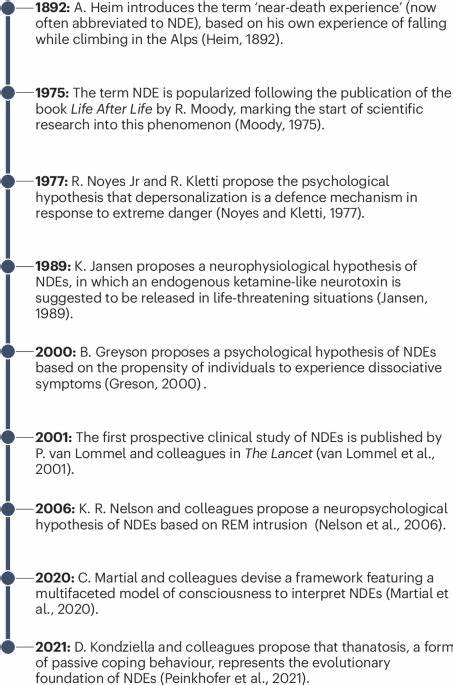

在过去的十年中,互联网的发展曾经掀起一场关于开放互联的浪潮。从Web 2.0时代开始,应用之间通过API实现无缝连接,数据与服务的共享让整个互联网生态日趋丰富和多样。开发者能够轻松调用其他平台的功能,用户享受到跨平台整合带来的便利体验,一度构建出一个理想化的互联背景生态系统。然而,这种梦想正在逐渐破灭,随着“防线升起”,连接变成了管制,生态逐渐封闭,原本畅通无阻的数据和服务如今被层层壁垒所阻挡。 这一转变的核心,可以从Web 2.0时代起步的API开放政策的演变窥见端倪。起初,每个应用都愿意提供开放的API接口,辅以标准化的规范,支持数据的自由流通和功能整合。

不少顾问公司因此获得了巨大的商业机会,帮助大型企业和政府搭建自己的接口,无数标准的出现与淘汰也推动了安全机制的不断完善。整个行业似乎朝着互联共赢的方向发展。然而,随着行业的集中和平台效应的增强,一些头部企业开始调整策略,逐渐收紧了接口的权限,将其变得复杂且带有多重限制。这种变化并非偶然,而是对竞争环境的响应,也是对数据控制权和平台商业利益的保护。 Twitter于2012年对第三方客户端的用户限制便是很好的例证。限制最多支持10万用户,最终完全切断了第三方客户端的使用权限。

这种转向一方面保障了平台的生态安全和盈利模式,另一方面也压制了竞争对手和开放创新的发展空间。与其类似的趋势在Facebook、Google等巨头身上也屡见不鲜:虽然依然开放一些针对广告和内容发布的接口,但对数据的消费和深度访问则严加限制。 随着人工智能和大型语言模型(LLM)的兴起,这样的生态壁垒正在快速形成并强化。多渠道平台(MCP)的概念曾引领业界对开放互联的美好期盼:通过让语言模型接入各种数据和应用,能够自动完成大量繁琐任务,为用户提供更智能化和个性化的服务。理想的情形是,人们可以利用统一接口,轻松调用各类服务,使得机器学习技术真正发挥出连接人与数据的价值。但现实并非如此简单。

各大平台往往拥有自己独立的人工智能系统,且更倾向于用户直接使用他们提供的AI产品,从中获取数据价值和商业利益。例如,Slack近期禁止第三方软件搜索或存储其消息内容;X(前称Twitter)更新开发者协议,禁止第三方使用平台内容训练大型语言模型。这些措施无疑拉起了防线,限制了数据的共享与开放。 类似案例还有Anthropic切断与Windsurf渠道的直接访问,原因与竞争对手OpenAI的收购传闻相关;Google减少对Scale AI的合作,背后是Meta取得该数据标注公司的权益。背后的逻辑是,数据已成为关键的护城河,不同公司的合作和竞争态势复杂且敏感。 在如此背景下,MCP更像是一种工具协议而非开创性运动。

它依然能够实现便利的LLM工具调用,但限制多、控制严。开发者可以为自己的应用搭建MCP接口,但无法期望借此轻松进入其他强大平台或挑战其主导地位。开放的互联网生态似乎被逐步取代,取而代之的是分裂而受控的数字场域。 这对未来互联网和人工智能的发展提出了深刻的挑战。一方面,保护数据安全、维护商业利益和用户隐私是不可避免的要求。另一方面,技术创新和用户体验的提升需要更开放和合作的环境支撑。

平台之间如何找到平衡点,既防范恶意竞争和滥用,又维护创新活力,将成为业界关注的重点。 值得注意的是,技术的演进本身并未停止。虽然互联生态变得封闭,但边缘创新依然活跃。中小企业、开源社区以及新兴的人工智能服务仍在努力突破这些限制,寻找到新的连接点和整合方式。这种生态的多样化,或许能在长期形成新的格局,重新定义互联的含义。 总体来看,从Web 2.0的自动开放,到如今看似不再自由的数字围墙,互联网的发展反映出技术进步与商业利益的复杂互动。

我们需要对这场变革保持清醒,理解限制造就的同时,也在催生新的机遇。对于用户而言,认识数字生态变化,合理利用各种平台资源,将是适应未来数字生活的关键。面对防线升起的现实,我们需要从开放梦想走向务实探索,推动生态持续健康发展,为下一阶段的网络时代奠定基础。