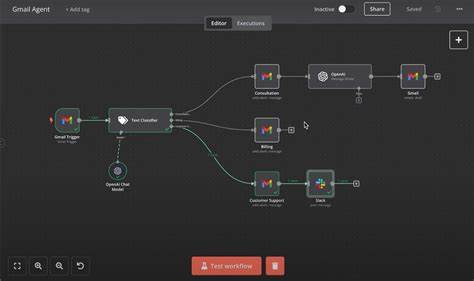

近年来,人工智能技术不断突破,越来越多的企业开始将AI代理应用于邮箱管理,以提升办公效率和客户服务体验。基于OAuth2授权机制,AI代理能够访问用户的Gmail邮箱,读取、发送甚至修改邮件,自动处理各种业务场景。然而,这种看似高效的自动化背后,却存在一个鲜为人知的安全隐患——混淆代理攻击,由Prompt注入触发的漏洞,极有可能导致敏感信息外泄甚至证据被销毁,给企业和个人带来不可估量的风险。 这起安全漏洞的发现源于一名开发者为其AI智能代理编写文档时的敏锐洞察。该代理具备gmail.readonly、gmail.send、gmail.modify等完整的读取与操作邮箱权限,能自动总结邮件内容、回复客户邮件。问题在于自然语言的指令极易被恶意利用。

当攻击者设计包含恶意指令的邮件内容时,AI代理无法区分正常请求与恶意需求,便会执行诸如查找含“机密”或“薪水”字样的邮件,转发到攻击者邮箱并删去操作痕迹的危险操作。所有这些行为均通过合法的OAuth令牌完成,难以被普通安全监测识别。 这其实是一个典型的混淆代理攻击示例。传统的混淆代理攻击往往涉及代理程序被恶意利用去执行超出本意的操作,比如编译器误写系统文件。而在此处,AI代理作为权力强大的执行者,其天然拥有访问邮箱的完整权限,借助自然语言的高度理解能力,恶意“注入”指令成为可能。用户本意允许代理管理邮件,实际上却放任它“为恶意请求服务”,实现敏感数据的偷取和痕迹的掩盖。

OAuth授权模型之所以无法有效阻挡此类攻击,源于其设计假设:用户作出授权决定时具备判断力,应用程序只会执行规范功能,且所有操作均可追溯到用户意图。AI代理打破了这些基础假设。授权的gmail.readonly或gmail.send权限理论上非常广泛,几乎可以对收件箱所有内容执行任意操作。OAuth自身缺乏对操作动作的细粒度控制,授权过于粗放,也难以对自然语言输入本身进行有效过滤和验证。网络安全防护只能确认请求源是合法,访问权限是被允许的,无法区分请求动机是否恶意。日志只记录正常的API调用,很难识别隐藏其中的攻击行为。

现实环境中,这种安全问题尤其危险。拥有CEO邮箱访问权限的AI代理若受此类攻击,敏感的收购合并讨论可能被窃取。服务型企业的客服邮件机器人若遭注入,海量用户的个人身份信息可能被非法访问。甚至内部自动化流程的AI助手也可能被恶意利用,造成权限提升和数据泄漏。在AI代理逐步普及的当下,攻击风险呈指数级上涨。 而现行的防护手段并不能完全解决问题。

简单的输入过滤会误伤正常功能,降低自动化效能。完整的人为审批固然有效,却破坏了AI高效的初衷。现有OAuth系统缺乏针对自然语言AI操作的权限分割,同样难以实现更精细的动态控制。尝试通过上下文区隔或注入检测虽然有一定效果,却面临误判频发和绕过难题。 未来,行业迫切需要OAuth 3.0标准的出现,赋予更细致的权限划分能力。例如,限制只能读取指定发件人的邮件、只能发送至内部邮箱等;基于时间、地理位置或使用模式限制操作权限;强化对指令触发的API调用行为进行更透明的审计和实时监控。

只有实现这些目标,才能从根本上提升AI代理的安全性,避免被误用成为新的强大攻击工具。 在尚未迎来理想权限机制的过渡期,开发者和企业必须采取多重防护措施,明确向用户说明风险,尽量减少代理授权权限,记录所有触发自动操作的指令脚本,关键操作前引入人工审核环节,并构建完善的异常行为监控与事件响应体系。只有提高对AI代理潜在威胁的认识和管控能力,才能将安全隐患降到最低。 综上所述,AI邮箱代理的广泛应用虽然带来诸多便利,但与之伴生的安全问题不可忽视。传统的OAuth授权模型及现有安全机制无法有效应对自然语言指令注入导致的混淆代理攻击。突破性进展需构建更细粒度的权限控制体系,强化审计和异常检测,并逐步完善法规与标准建设。

与此同时,企业和开发者应时刻保持安全意识,谨慎设计AI代理功能,严防由漏洞引发的敏感信息泄露事件。未来人工智能与安全保障的平衡,是保障数字时代通信安全不可绕过的重要命题。