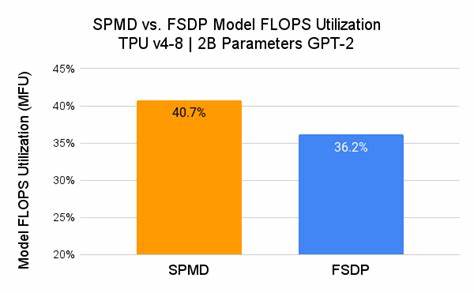

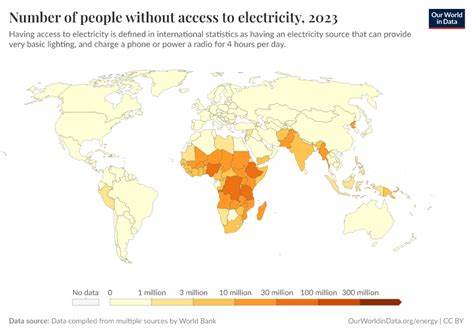

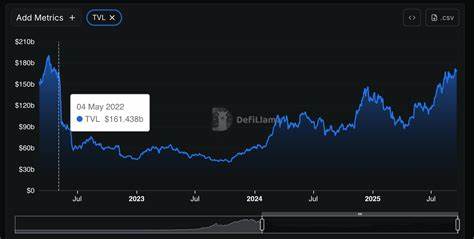

模型FLOP利用率(Model FLOPs Utilization,MFU)作为衡量人工智能模型在计算资源使用效率上的重要指标,近年来被广泛应用于训练与推理阶段的GPU资源调度和性能评估。随着AI技术的迅猛发展,数百亿美元的计算资源投放到模型训练和推理中,如何精准评估并优化这部分巨额投入的计算效率,成为业内亟需解决的关键难题。传统的MFU估算方法多基于一个被称为"6ND"的粗略模型,然而这一计算方式在面对现代大规模模型的复杂计算特性时,暴露出诸多不可忽视的不足。这篇深入探讨将带你透视6ND模型的假设前提,揭露其局限所在,并展示如何在实际应用中超越6ND模型,进而实现对AI计算资源的更合理利用和优化。过去一年,全球AI数据中心耗电量高达约415太瓦时(TWh),即便按最低成本估算,电费支出也轻松超过200亿美元。如此庞大的开销不仅意味着巨大的经济负担,也催生了对计算效率指标更加严苛的需求。

MFU正是在这一背景下应运而生,其核心目标是量化设备算力的实际利用率,指导开发者发现和解决资源浪费,驱动模型和系统效能的提升。传统的6ND模型基于三个关键假设:首先,每个模型参数对应一次乘加操作,计为两次FLOP(浮点运算次数);其次,模型训练的反向传播开销是正向推理的两倍,因此训练总开销是推理的三倍;最后,整个训练过程都是计算受限(compute-bound)而非内存或带宽受限。然而,当这些假设应用于规模日益庞大的现代AI系统时,问题逐渐浮现。以乘加操作对应两个FLOP作为基础计算单位,在实际中往往无法涵盖注意力机制带来的非线性复杂度。特别是注意力的计算复杂度并非线性,而是通常呈平方级增长,随序列长度爆炸性上升,极大地影响了整体计算成本和效率。随着Transformer及其衍生模型广泛采用注意力机制,单纯依赖N(参数量)和D(序列长度)线性关系描述FLOP的6ND模型,对准确估计计算需求显得力不从心。

除序列长度相关计算外,混合专家模型(MoE)引入了积极参数活跃度的复杂计算。传统的6ND计算以总参数数量为基准,但MoE模型中仅使用了其中部分专家,实际激活参数远小于总参数数目,若不做精细区分则会严重高估计算量。这使得MFU的计算变得更为复杂且容易出错,需要引入"稀疏因子"和专家激活统计,才能贴近真实计算水平。在训练和推理部署规模极速膨胀的背景下,超大规模分布式系统广泛采用多种并行策略,包括模型并行、数据并行、流水线并行及专家并行等多层次并发,进一步加剧计算资源利用的统计复杂性。简单乘除GPU数量来估算并行度固然便捷,却忽略了并行策略间的重叠和交互影响,导致MFU度量偏差加大。推理阶段的实际情况尤为复杂,因线上服务请求多为异步且瞬时性强,无法形成理想批处理行为,设备负载波动较大,MFU随时刻变化,难以用静态指标准确支撑性能分析和资源调度。

加之预填充(prefill)和解码(decode)阶段采用分离硬件资源执行,导致这两个环节的MFU指标差异显著,不加区分评估很容易产生误判。现代推理还引入了KV缓存机制,极大缩减了后续计算的序列长度,N参数不再是简单的输入序列全部长度,而是新增令牌数,传统6ND模型无法合理反映真正的计算开销。此外,投机性解码是一种常见的推理优化技术,通过提前预测多个候选输出并验证筛选来提升响应速度,但它引入了大量额外的计算资源投入。这种策略带来的额外FLOP若未被正确归入总计算量,会造成MFU指标超过100%的异常现象,误导优化判断。针对这些实际问题,研究者开始尝试更细粒度和精细化的MFU计算方法。例如在vLLM社区提出的相关Pull Request中,分为简化版和基于PyTorch执行图的两种计算方案。

简化方案在传统6ND基础上引入MoE稀疏因子,更合理地计量激活参数数目,虽然仍未完全解决所有细节,但适合日常性能监控,计算开销极低,可实现每步计算即时MFU反馈。更为先进的方案则依赖PyTorch 2.0的torch.compile功能,利用其生成的执行图遍历各算子节点,断定每个节点的具体FLOP及内存读写量,以精准刻画计算资源消耗结构。此种方法不仅能够识别哪些算子是计算瓶颈,哪些是内存带宽限制,还能对模型不同模块、算子实现甚至内核级别展开细节分析,为性能优化提供科学依据。这也反映出现今MFU指标向着细粒度和场景定制化方向演进的趋势。尽管如此,MFU仍有其固有限制和适用边界。它无法跨模型和硬件平台进行绝对比较,更多是作为同一系统和任务内部的相对性能指针,帮助发现运行效率的波动和潜在改善点,却并非万能钥匙。

结合顶线模型如roofline模型,以及更加丰富的性能指标体系,才能实现满级别的性能提升指导。未来MFU的优化方向可能包括动态按模块、算子或核函数拆解统计利用率,融合硬件特征实现真实峰值性能逼近度的评价,也可能结合在线学习与自适应技术,在训练与推理服务过程中持续调整资源分配策略。总体来看,突破6ND模型FLOP利用率只是迈向更加科学和精准AI计算效率度量的一步。面对日益复杂的模型结构和多变的计算场景,我们需要不断深化对计算成本构成的理解,在实际生产环境中取得更加贴合真实的性能评估。只有如此,才能更有效地指导模型架构设计、硬件采购及系统调度,实现投入产出比的最大化,从而推动AI技术在成本控制、性能释放和可持续发展方面迈出坚实步伐。总结来看,MFU作为衡量计算资源使用效率的关键指标,虽然传统6ND公式带有诸多简化假设,但仍是行业衡量基础。

随着模型架构进化、计算场景复杂度上升,仅借6ND已无法满足精细优化需求。引入注意力计算权重、专家模型稀疏激活、并行策略复杂度和异步推理负载等因素,构建基于执行图的细粒度MFU分析框架,将为AI研发和运营带来更精准的性能洞察。这样的技术演进不仅节省了巨额的电力和硬件开销,也助力实现环境可持续、经济高效的AI发展。随着开源工具和编译技术的迭代,未来更加灵活、动态和智能的MFU评估体系有望成为AI算力管理的标配,帮助行业在激烈竞争中保持领先,为全社会带来更具价值的智能体验和创新成果。 。