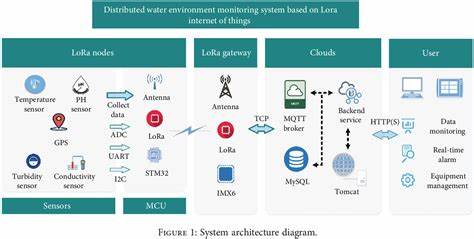

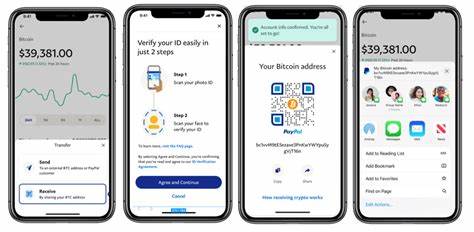

随着分布式系统规模的不断扩大和复杂度的提升,如何高效地管理和优化模型参数成为开发者和研究人员面临的重要挑战。异步低秩适应(Async LoRA)技术作为一种创新性的方法,正在逐渐成为分布式系统中的重要工具。本文将详细介绍异步LoRA的概念、技术优势及其在分布式环境中的实际应用,帮助读者深入理解这一技术如何为现有系统带来性能革命和运行效率的显著提升。 分布式系统主要通过多个节点协同工作来处理庞大且复杂的计算任务,然而,随着模型规模的增大,传统的参数同步方式往往导致通信开销巨大和计算效率下降。针对这一问题,低秩适应(LoRA)被提出作为一种参数高效调优的技术,通过引入低秩矩阵分解来减少需要更新的参数数量,而异步LoRA则进一步打破了同步更新的束缚。 异步LoRA的核心优势在于其非阻塞的参数更新机制,使得各个节点可以在无需等待其他节点完成更新的情况下,独立并行地进行模型参数调整。

这样的设计极大地降低了通信延迟,提高了整体训练的吞吐量,并充分利用了分布式计算资源。这对于需要频繁且快速适配的新兴应用场景,诸如在线推荐系统、自然语言处理模型以及图像识别等领域,具有重要意义。 技术层面,异步LoRA利用低秩矩阵技巧,将大规模的模型参数拆分为可单独调整的小块,从而使参数更新变得更加灵活并且高效。在传统同步方法中,所有节点必须等待彼此完成更新,这不仅延长了训练时间,还增加了系统对网络状况的依赖。而异步方法允许节点自由调整并提交自己的更新,系统通过合并各个节点的改动来不断优化模型,显著提升了模型训练的鲁棒性和容错能力。 此外,异步LoRA尤为适合现代云计算和大数据平台中分布式深度学习框架的部署。

云服务提供商和企业级应用常面临网络带宽受限和节点异构的挑战,而异步机制的引入有效缓解了这些限制。节点之间的松耦合结构不仅简化了系统架构,还提升了系统的扩展性,使得更多计算资源能够被灵活调配和利用。 异步LoRA的应用案例也不断涌现。例如,在大规模语言模型的训练过程中,异步LoRA确保了模型参数能够及时响应数据的变化,实现快速在线更新。此外,在多任务学习和迁移学习场景中,异步LoRA通过高效的参数共享机制,促进了知识传递和模型泛化性能的提升。其不仅加快了模型的开发周期,也显著节省了计算资源的投入。

实践中,实现异步LoRA需要解决一系列技术难题。数据一致性和参数冲突管理成为关键难题之一。由于各节点异步更新,如何保证参数的合理融合,避免模型性能下降,是设计异步算法时必须考虑的问题。同时,系统需要具备强大的监控和日志机制,以便及时捕捉异常更新并进行恢复。尽管困难存在,但通过合理的算法设计和系统架构优化,异步LoRA已经展现出良好的稳定性与效果。 展望未来,随着分布式系统对实时性和可伸缩性的要求日益提高,异步LoRA将扮演更加关键的角色。

结合人工智能领域的最新进展,如联邦学习和边缘计算,异步LoRA有望实现跨地域、跨设备的高效参数协同,推动智能系统进入更加智能化和自适应的新时代。它不仅为科学研究提供了强大工具,也为产业升级注入了新动力。 综合来看,异步LoRA的出现打破了传统分布式模型训练的瓶颈,为系统优化和性能提升提供了创新途径。其灵活高效的参数更新机制,使得分布式环境下的深度学习模型能够更好地适应复杂多变的应用需求。无论是从理论研究,还是实际应用角度,异步LoRA都展现出强大的生命力和广阔的发展前景,对于推动人工智能技术在各领域的落地具有深远意义。未来,随着相关技术的不断成熟,异步LoRA必将成为分布式系统中不可或缺的核心工具,助力智能计算迈向更高层次。

。

![探索Java编程中的核心入口方法public static void main(String[] args)为何在2025年被新简洁的代码风格取代,揭示这场变革背后的技术进步与编程理念转变。](/images/99A6589D-479A-47EA-9DF5-B37B33B4DA10)