随着人工智能对话系统的广泛普及,Claude和ChatGPT等自然语言处理模型已经成为人们日常交流和工作的重要工具。在这些对话系统的用户界面中,Token计数器作为一个基础但关键的组件,直接影响着用户输入的管理和模型交互的效率。所谓Token,指的是模型处理文本时所切分的基本单位,理解并有效监控Token的数量,对于保证模型响应的速度、成本控制和输入输出质量都至关重要。简易Token计数器,顾名思义,是一种功能简单但实用的工具,它通过对用户输入文本进行实时统计,帮助用户和开发者直观了解正在处理的Token数量,实现对文本长度的有效把控。Claude和ChatGPT的界面集成这类计数器,主要是为了优化使用体验,避免因超长输入引发模型处理错误或响应延迟。实际应用中,Token计数器的精准度和响应速度直接决定了用户与AI交互的流畅度。

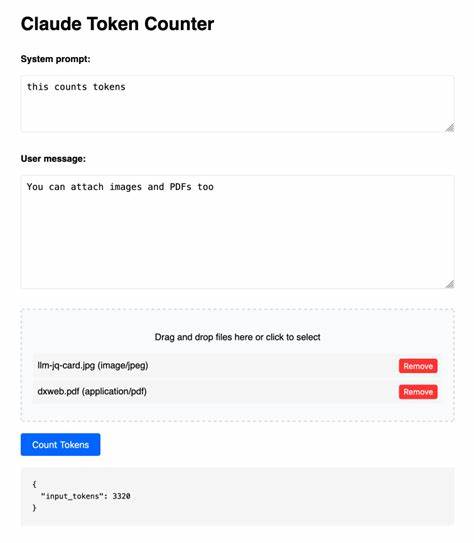

设计简易Token计数器时,首先需要基于模型的分词规则进行合理的文本切分。尽管不同模型存在分词差异,但大多数现代语言模型采用的是基于子词(subword)或者字节对编码(BPE)的分词策略。这种切分方法兼顾了语言的复杂性和处理效率,使得Token计数器能够准确反映文本在模型内部的处理单元数。为了提升计数器的实用性,开发团队通常会将其嵌入用户输入框附近,以便用户能够在输入过程中实时观察词数变化。这样的设计有效避免了用户无意识地输入过长文本,而导致模型无法正常处理或产生额外的处理时间和费用。同时,简易Token计数器还可以结合界面中输入限制和提示功能同步工作。

当检测到Token数接近或者达到设定上限时,系统会发出警告或自动阻止继续输入,保证对话流程的顺畅。除此之外,计数器也便于开发者分析用户使用习惯与对话内容的复杂度,为后续功能优化和资源分配提供数据支持。而在具体实现层面,简易Token计数器通常采用轻量级的JavaScript函数或其他脚本逻辑,通过调用模型的分词API或者本地分词算法进行Token计算。此类设计考虑了性能开销和易用性,避免了复杂后台调用,确保计数器响应快速且不会拖慢整个界面的表现。随着对话应用的不断发展,越来越多功能丰富的计数器开始涌现,比如增加历史上下文Token统计、支持多语言编码检测、甚至自动压缩和优化输入文本内容以减少Token消耗。不过,对于大多数普通用户和基础应用场景,简易Token计数器依然是最便捷且实用的解决方案。

通过合理利用这一工具,用户不仅能够节省模型调用成本,还可以更清晰地理解文本对模型资源的占用情况,提升整体交互体验。总结来看,简易Token计数器虽然设计简单,但在Claude和ChatGPT等对话系统的实际使用过程中发挥了不可忽视的作用。它有效桥接了用户与复杂语言模型之间的交互,为保障输入的规范性和产出质量建立了基础。未来,随着技术进步与应用场景的丰富,Token计数工具将持续进化,带来更加智能化和个性化的用户体验。理解其核心原理和功能特性,有助于开发者更好地设计界面,提升系统的易用性以及模型运算效率,也使得用户在日常对话中享受更流畅且高效的AI服务。 。