在计算机科学中,浮点数的表示和运算常常因有限的存储位数而导致误差。常见的舍入方式,如四舍五入或向零舍入,虽然简单易用,但在大量运算中可能产生累积偏差,影响最终结果的准确性。尤其在科学计算、机器学习训练等需要大量浮点运算的领域,舍入误差的累积可能导致显著的偏差和性能下降。这时,一种称为"随机舍入"(Stochastic Rounding)的技术开始受到关注。随机舍入通过引入随机性,使舍入误差以零均值随机变量的形式出现,从而弥补传统确定性舍入的不足。了解随机舍入,必须先回顾计算机浮点数的本质。

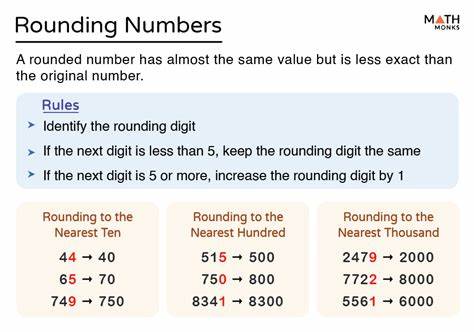

以IEEE 754标准为例,浮点数通常分为单精度(binary32)和双精度(binary64),分别代表32位和64位的有限存储空间。由于二进制表示的限制,很多十进制实数无法被完全准确表示。例如简单的0.1在浮点表示中就存在微小差异。计算0.1 + 0.2时,人们常惊讶于结果不等于0.3,实则是计算机底层二进制表示及浮点运算的固有特性。传统浮点数舍入方式多基于四舍五入,即取距离目标值最近的浮点数表示。然而,随着计算步骤的增加,这种确定性舍入方法的误差会不可避免地逐步偏离真实值,导致数值计算结果产生系统性误差。

随机舍入以概率性方式舍入到相邻两个候选浮点值之一,其概率正比于目标数值与两个候选值的距离关系。简单说,如果某个数值落在两个浮点数之间,比如x落在down和up之间,随机舍入会以(x - down)/(up - down)的概率舍入到up,否则舍入到down。这样,舍入误差在多次操作中呈现零均值,避免了系统偏倚。随机舍入的实现依赖于底层的随机数生成及精确的上下界确定。在C语言中,可以利用库函数rand()生成0到1之间的均匀随机数,用nextafterf()函数精确找到目标值上下相邻的单精度浮点数。基于这些,开发者可以用类似如下伪代码实现随机舍入:首先确定目标double精度数值转换为float类型的最近上下界值down和up,然后生成随机数根据概率选择返回up或down。

这样,一次舍入操作的结果具备随机性,但长期多次操作的统计意义上误差趋近于零。随机舍入的价值在于减少数值运算中的累积误差。一项用π为测试对象的实验表明,将高精度的双精度π数值通过随机舍入多次转化为单精度,统计结果的平均值更接近真实π值,明显优于传统的简单截断或四舍五入。这体现了随机舍入对数值精度的有效提升。设想一个大城市中布满高级温度传感器,它们采集环境温度精度很高,但数据仅能通过带宽受限的网络传输,将数据精度限制在32位。若采用传统舍入方法,类似20.55、21.55、22.55摄氏度的温度,均可能被统一向上舍入,造成整体平均温度偏高。

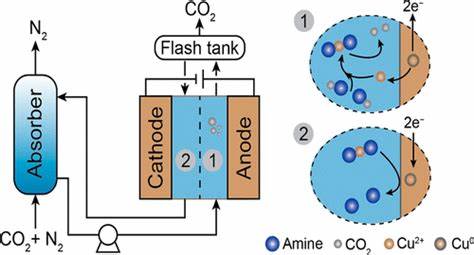

随机舍入则赋予每个测量值向上或向下舍入的概率,根据其与邻近浮点数的距离概率分布,传感器的数据更为真实地反映整体环境温度,避免系统性偏差。在实际数值计算场景中,随机舍入对训练大型神经网络等基于梯度下降的优化算法表现出积极影响。梯度下降算法通常涉及大量微小的浮点权重更新,传统舍入方法可能让权重累计产生偏移,降低训练的准确度。通过引入随机舍入,每次更新的舍入误差均衡分布,经过多次迭代,其误差均值趋近零,从而使得训练过程更接近于高精度浮点环境下的理想表现。具体微基准测试结果显示,采用随机舍入与传统舍入相比,训练权重与高精度参考值偏差的均方根误差降低了约14%,提升虽不剧烈但足以验证随机舍入在实际应用中的实际价值。此外,随机舍入还具有良好的误差界限表现,已在向量内积、矩阵乘法及求和运算中被证明优于传统"四舍五入"等舍入模式。

随着硬件技术的发展,特别是低功耗边缘计算设备不断增多,对存储及计算资源有限的场景中随机舍入愈发重要。它能在保证有限位数存储和计算的同时,减轻误差积累带来的不良影响。尽管随机舍入带来随机性,可能导致单一实验的结果优劣参差不齐,但从统计意义上看,其误差无偏化的特质帮助减少了整体的数值偏差,在科研计算、机器学习、高性能计算等多领域拥有潜在应用前景。总结而言,随机舍入作为一种非确定性的浮点舍入方法,有效平衡了精度与误差,减少传统舍入方式带来的累积偏差。通过概率性舍入接近真实值,随机舍入保证了误差的零均值,尤其适合需要大量小幅度浮点数更新的应用环境。随着数值需求的不断攀升,随机舍入或将成为未来浮点计算的重要工具之一,为计算科学和数据处理领域带来更高的精度和可靠性。

。