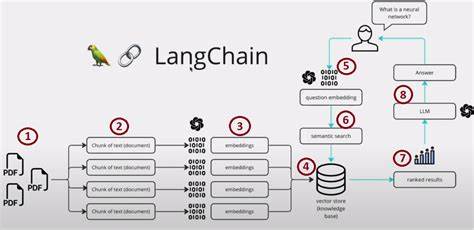

随着人工智能技术的迅猛发展,大型语言模型(LLM)在自然语言处理领域的影响力日益突出。2024年,围绕LLM的研究步伐持续加快,众多突破性的创新成果不断涌现,涵盖了模型架构、效率提升、偏好优化、指令调优、多模态融合、长上下文学习、推理能力、量化压缩、评估基准以及应用场景等多个方面。本文将带您深入了解这些显著的研究成果并解析它们在推动AI行业发展的重要意义。 研究论文集合囊括了超过500篇近期发布的突破性作品,涵盖了LLM各个维度的创新。首先,在模型架构与效率优化方向,研究者们致力于设计更加高效且强大的模型结构。这些作品通过创新的神经网络设计、混合专家架构及稀疏注意力机制,极大地降低模型训练与推理时的计算资源消耗,实现了在保证性能的前提下,有效提升速度与规模。

例如,自适应混合专家结构为大型模型的参数扩展提供了灵活的途径,从而使得训练和部署更加经济高效。偏好优化和基于人类反馈的强化学习(RLHF)也成为热门话题。研究探讨了如何通过人类偏好标注以及直接偏好优化算法,让模型的输出更加符合伦理道德要求,避免产生危险或误导性内容。论文中提出多种奖励建模技术与反馈机制,提升了模型在实际应用中的安全性与可信度。多模态模型方面表现尤为亮眼。新兴的研究突破了传统单一文本输入的限制,融合了图像、视频、音频等多种数据形态,从而实现了对复杂信息的综合理解与生成。

多模态大模型不仅在视觉问答、图像生成以及综合多媒体分析上展现出卓越性能,也为自动驾驶、医疗图像诊断等领域带来了切实可行的解决方案。这些跨模态融合技术为智能系统注入了全新的感知能力,极大拓展了AI的应用边界。 另外,长上下文学习和推理也是无数关注焦点。传统LLM的上下文窗口一般有限,限制了它们处理长文档和多轮对话的能力。针对这一痛点,众多研究提出了激活灯塔机制、稀疏注意力以及分布式缓存量化技术,以实现上下文长度的指数级扩展,令模型能够处理上百万甚至千万级别的输入长度。这些突破不仅提升了模型的记忆力和连贯性,同时也促进了多轮复杂任务的推理能力和准确度。

推理与知识的有机结合是LLM迈向智能化的重要一环。最新文献中强调了如何借助复杂推理算法、符号表示以及世界知识图谱,帮助语言模型更好地理解和解决实际问题。许多论文以几何视角、机制性设计等角度探索模型“思维”过程,揭示了深层次的认知规律。与此同时,量化和压缩技术则在模型优化和实际应用推广中发挥着关键作用。研究覆盖了低精度计算、1位量化、层间权重分解等多种创新手段,实现了性能与资源使用间的最佳平衡,使得大模型在移动设备和边缘算力环境中同样具备可行性。 评估与基准建设是推动领域规范发展和技术进步不可或缺的环节。

大量论文聚焦设计新颖、高难度的测试集与评价框架,强调对模型在稳定性、可靠性及多样性方面的全面评估。这有效促进了学术界和工业界对模型能力的客观与系统认知,尤其在多模态评测、长文档理解以及安全对抗等方面的评测体系日益完善。指令调优与模型对齐方向在各大研究中均有突破。通过更为精准的指令设计与调优算法,模型在执行用户复杂需求时表现得更加灵活和高效。同时,结合持续微调、自适应架构调整等技术,使得模型能够更好地理解上下文指令、减少偏差、增强交互体验,为智能助理、教育培训、代码生成等多样化应用提供强有力支持。大量综合性调查与元分析研究则为AI从业者提供了全面的趋势解读和技术洞察。

深入挖掘各类方法的优劣、适用场景及未来挑战,助力研究者及开发者选择合适的技术路径,推动实际产品的创新迭代。最后,应用与工具领域的研究成果充分展示了大型语言模型在各式行业中的变革力量。从医疗、法律、金融到编程和内容生成,前沿论文揭示了如何合理利用LLM解决现实问题并打造智能化应用,用数据和实践证明了AI的巨大潜力和商业价值。 总而言之,2024年的大型语言模型研究格局呈现多元创新、跨界融合的态势。技术层面涵盖从底层模型架构调整到高层任务优化的全链路革新,应用层面则体现出向多模态、长上下文推理、安全对齐方向的深度拓展。这些研究不仅彰显学术界的活力,更直接推动了人工智能技术向更加智能化、实用化的未来迈进。

对人工智能爱好者、技术开发者以及行业决策者而言,紧跟这些前沿论文的研究动态无疑有助于捕捉时代脉搏,抢占技术制高点。未来,随着更多创新方法的涌现和产业生态的完善,LLM将在赋能各行各业、推动智能化进程中发挥不可替代的核心作用。持续关注并深入理解这些开创性工作,意味着掌握了引领数字智能时代的关键钥匙。