在人工智能领域,随着大型语言模型(LLM)能力的迅速提升,越来越多的研发团队和企业为它们设计了与操作系统终端交互的接口,从而赋予模型执行Bash命令、管理文件和运行复杂编程环境的能力。然而,终端工具的背后隐藏着极其复杂的计算理论难题,其中尤以“停机问题”为代表,极大地考验着开发者在设计终端解决方案时的思考深度和技术水平。理解LLM如何与终端交互不仅能提升代理程序的稳定性和效率,还能有效避免因命令执行造成的阻塞、错误和安全隐患。现阶段主流的终端实现可分为两类:一种是即时执行的子进程模式,另一种是持续会话的伪终端模式。子进程模式下,每条由模型生成的Bash命令直接被操作系统以独立进程的形式执行,运行结束后返回结果,这一模式简洁高效,易于实现。它在初期阶段曾被广泛采用,甚至被OpenAI Codex等系统作为参考实现。

然而这种方式暴露出多种局限。其一是无法支持需要持续交互的命令,比如REPL(如python3或node),这类命令需保持会话状态持续响应输入,子进程模式无法满足。其二是面对部分命令可能需要用户输入的情况,单次调用难以提供交互接口,导致程序挂起或超时。开发者尝试通过设置环境变量避免交互,或通过命令参数强行禁止交互输入,但这些只是权宜之计。再者,执行超时成为另一个不可避免的问题。子进程执行模型只能设定固定时间窗口,稍长任务就可能被强制中断,因而无法可靠处理复杂编译或持续构建等操作。

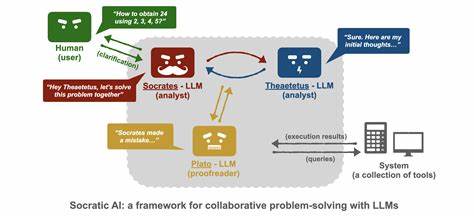

节点运行时如Node.js的child_process模块和更高效的Bun runtime虽然简化了实现,却无法根本缓解这些固有问题。持续会话模式应运而生,旨在构建一个可持续交互的伪终端环境。此模式通过维持一个长连接的Bash会话,模型可以不断地向这个终端发送命令,接收实时反馈,仿佛一个真正的人类用户在操作终端。尤其是在构建复杂的自动化脚本和多步推理场景中,这种模式表现得更为灵活和强大。业内著名的node-pty库,作为微软VS Code终端背后的技术支持,成为实现持续会话的理想工具之一。然而,这带来了全新的挑战:如何判定终端何时完成某条命令,何时进入等待用户输入的状态?这一问题本质上接近计算机科学经典难题停机问题的实践映射。

停机问题指出,无法设计一个算法判断任意程序是否会在有限时间内结束,亦即终端无法总是确定命令是否真正“完成”。为解决这一困境,社区和企业尝试了多种技巧和启发式方法。最为常见的是基于超时的策略,设定等待输出稳定的时间阈值,若在该阈值内无新增输出,则认为命令已结束并返回结果。然而这忽略了诸如docker build --quiet这类静默执行的长时任务,输出立即“稳定”却仍在持续运行。针对这一挑战,部分实现引入了特殊的“哨兵值”机制,即在每条命令后自动附加一个唯一的标识符命令(例如echo特定字符串),通过监测此字符串的输出出现来判断命令终结。此机制提高了判定准确率,但仍不能涵盖启动交互式REPL的情况。

另一种探索方向是利用系统调用追踪(如strace)监控伪终端的进程状态,以推断是否处于等待输入阶段。虽然理论可行,但实际操作因权限限制和多样化系统调用表现而颇为复杂,尚未形成可靠的通用方案。终端输出的稳定性检测也成为判定关键点之一,通过观察输出内容的变化率和延迟判断是否应继续等待。开发团队对输出稳定性的收敛时间需进行权衡,既不能过长以免用户体验下降,也不可过短导致截断完整数据。此外,解决方案还须考虑脚本中包含控制字符、箭头键等交互式输入的正确传递,确保高保真终端使用体验。基于对上述问题的总结,设计一个稳健的LLM终端工具不仅需要深厚的系统编程知识,更离不开对用户场景的深入理解和合理折衷。

为了安全起见,多数代理会在隔离的虚拟机(如Firecracker)中运行,保障系统不被潜在恶意代码影响。同时,通过指令规范、超时策略和限制命令类别等手段,减少异常状况。总的来看,尽管停机问题理论上无法完全解决,开发者通过实现一套适用于绝大多数日常任务的实用方案,已实现了令人满意的终端交互体验。展望未来,随着硬件性能提升和智能策略的发展,智能终端交互工具必将更加智能化、适应性更高,为大规模语言模型的广泛应用奠定坚实基础。企业和社区的持续努力也将推动更多创新算法和技术诞生,进一步缩小理论困境与实际需要之间的鸿沟。对于关注LLM终端交互的开发者和技术研究者而言,深入掌握不同实现方案的优劣、敏锐捕捉实际应用需求,以及持续跟踪前沿研究成果,将成为实现高效、安全、智能终端操作的关键。

。