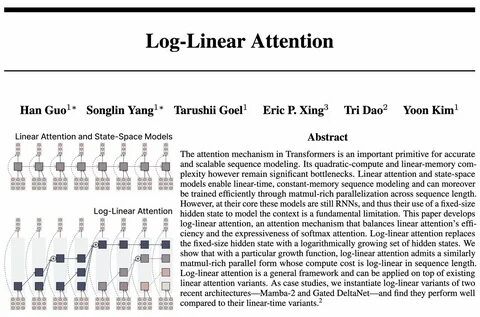

在人工智能特别是自然语言处理领域,Transformer模型因其强大的序列处理能力和出色的表现,成为当前研究和应用的主流技术。然而,传统Transformer中的注意力机制虽然功能强大,但其计算复杂度为二次方级别,随着序列长度增长,计算和内存负担急剧增加,限制了模型在处理超长序列时的效率。为了突破这一瓶颈,研究者们不断探索更高效的注意力机制,其中Log-Linear Attention应运而生,带来了一种兼顾计算效率和表现力的全新思路。 Transformer的核心是注意力机制,通过动态地为输入序列的不同部分赋予权重,实现对信息的选择性聚焦。标准的softmax注意力机制计算复杂度为序列长度的平方(O(n²)),这在处理中长序列时不仅耗时且内存消耗极大,难以扩展到工业级的应用。近年来,出现了多种线性注意力机制尝试将计算复杂度降至线性,从而实现更快的训练和推理。

虽然这些线性注意力方法在效率上取得了显著进步,但由于其本质上依赖有限维度的隐藏状态进行上下文建模,模型的表达能力和捕获长范围依赖的能力受到限制。 Log-Linear Attention从根本上改写了这一限制。它通过引入对数增长的隐藏状态集合代替固定大小的隐藏状态,构建了一种介于线性和标准softmax注意力之间的新范式。该机制能够在保证算力需求大幅降低的同时,提高模型的表达能力。具体而言,Log-Linear Attention设计出特定的增长函数,使得其并行化程度极高,能够充分利用现代深度学习硬件的矩阵乘法优化优势。此外,其计算成本达到了介于线性和平方之间的对数线性复杂度(O(n log n)),显著提升了在长序列处理中的性能和效率。

这种方法不仅是理论上的突破,还被成功应用于现有的线性注意力架构中,比如Mamba-2和Gated DeltaNet,通过实验验证了其在保持高效的同时提升模型性能。相比纯线性注意力模型,Log-Linear Attention在捕获序列内部复杂依赖关系方面表现更佳,同时依然支持大规模数据的快速训练和推理。 这背后的关键优势在于:传统线性注意力由于隐藏状态固定尺寸,往往难以保留足够的信息表达复杂上下文,而Log-Linear Attention通过动态调整隐藏状态数量,逐步丰富模型对输入的理解层次,极大增强了序列信息的表达维度。另一方面,相比于耗费巨大计算资源的softmax注意力,Log-Linear Attention技术有效降低了计算资源的需求,使得在硬件资源有限的环境下,也能实现高质量的序列建模。 在未来人工智能的发展路径上,Log-Linear Attention有望成为处理超长序列的核心技术。不论是文本生成、语言理解,还是基因序列分析、时间序列预测,这种新型注意力机制都能带来更高的计算效率与准确性。

在实际应用中,它为开发者提供了在保证模型表现的前提下,降低计算成本的有力工具,极大推动了Transformer模型向更大规模、更复杂任务的拓展。 总体来看,Log-Linear Attention是Transformer注意力机制发展历史上的重要里程碑,融合了可扩展性与强表达能力的优势。从理论到实践的全面提升,不仅有助于解决现有模型的瓶颈,还将激发更多创新的序列模型设计思路。随着这一技术的不断完善和推广,人工智能在自然语言处理及其他序列相关领域的应用必将迈入一个全新的阶段,助力推动智能系统向更高效、更精准的方向发展。