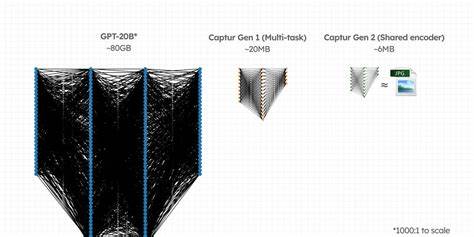

在现代移动设备上运行先进的人工智能模型一直面临着性能与资源使用之间的巨大矛盾。尤其是在物流、配送以及移动出行等应用场景中,每一次操作的延迟都可能直接影响到安全和用户体验。然而,受限于手机的计算能力和存储空间,传统高性能的AI模型往往体积庞大,运行缓慢,难以在移动端实现高效部署。Captur公司近期带来了令人振奋的突破,成功将多任务AI模型压缩到小于10MB的体积约等于一张普通照片的大小,同时在iOS和Android设备上实现了实时30FPS的高性能推理,不仅保持了模型的准确性,甚至实现了性能提升。这样的成果正在重新定义移动端AI的可能性,开启行业新的里程碑。 传统移动AI部署的挑战众所周知,单一任务的模型体积通常在10至20MB之间,涉及多个工作任务时,模型大小会乘以任务数量,迅速膨胀到数十MB,这对手机的存储和运行速度产生极大负担。

更严重的是,在内存紧张和处理能力有限的设备上,运行大模型会导致系统响应变慢,甚至出现卡顿,从而影响用户体验。为解决这一难题,Captur提出了一种全新的共享编码器架构。这种设计不同于传统的多模型独立推理,它通过知识蒸馏技术,将多个专门模型的知识融合并压缩到一个统一的紧凑模型中。结果显著降低整体模型大小,从传统模型打包的近20MB减少约71%,降至令人惊讶的6MB左右。这个尺寸相当于你手机相册中的普通照片大小,彻底打破了"高精度模型必须庞大"这一常规认知。 压缩模型的目标往往是牺牲一定的性能来换取更快的速度和更小的体积,但Captur的实验结果令人震惊。

压缩后的多任务共享编码器模型不仅没有因体积变小而降低性能,反而在多个关键任务上实现了性能跃升。例如,在道路危险检测这一重要应用中,传统单一任务模型体积高达200MB,其精确率(PR AUC)为84.65。而Captur的压缩多任务模型体积仅不到10MB,精确率却提升至93.38,实际性能提升达到5%至8%。除了准确率的提高,推理速度提升也极为显著,一次推理速度缩短到原来的三分之一,实现了真正意义上的实时30帧/秒处理能力。 这一反常现象的背后是跨任务学习的优势。多任务模型借助共享的编码器层,从多个任务中提取丰富且互补的特征信息,使得不同任务的数据相互强化,模型学习到的表征更为全面和有效。

比如,车辆合规性检测任务借助路面危险检测和车辆定位的上下文信息获得了更准确的判别能力,避免了以往单任务模型分别训练时的重复劳动和信息孤岛问题。由此,Captur为移动端AI建立了更智能、更高效的学习机制,而不是简单地压缩模型参数。 面向多样化手机硬件平台的一致性能表现是工业落地的另一大考验。iOS阵营有苹果神经引擎(Neural Engine)统一调度模型,加速设备端AI应用,而Android设备则存在极大硬件异构,从高端旗舰搭载专用神经处理单元(NPU)到低端机型依赖OpenGL,性能差异显著。Captur团队在架构优化和跨设备深度测试上下了大功夫,成功实现了iOS和Android设备上的性能接近统一。无论是最新款iPhone,还是三年前的安卓手机,用户均可享受到流畅稳定的30FPS AI推理体验。

这种跨平台的兼容性极大提升了模型部署的普适性和商业价值。Captur的创新不仅在于技术压缩和性能提升,更在于构建了一套完善的多任务学习和移动端优化方案,为现代物流、配送平台及移动出行等场景提供了强大而轻量级的AI支持。 随着AI技术在移动设备上的持续普及,对模型体积和速度的苛刻要求只会日益提高。Captur已经清晰地指明了未来的发展方向 - - 在保证模型轻量化和高速运行的同时,持续扩展任务能力而不牺牲性能。未来,Captur团队计划进一步增加新的任务类别,并在不增加显著存储和计算负担的前提下,实现持续的性能改进和多样化功能拓展。这将使人工智能能够真正无缝嵌入到人们的日常生活和行业应用中,促进交通安全、合规管理及智能物流的全面升级。

总体来看,Captur通过其共享编码器多任务压缩模型,打破了"体积减小必然带来性能下降"的旧观念,展现了技术上的重要革新。模型体积减少71%,性能提升5%~8%,实时推理速度提升三倍,成功在碎片化移动设备环境中实现稳定运行,代表了移动端AI的最前沿技术水平。未来,这种模型压缩与多任务协同学习的结合无疑将在更多本地AI推理场景中发挥巨大作用,推动智能设备更快更精准地响应现实世界的复杂需求。对物流公司、配送平台、出行服务商而言,这意味着可以无忧部署高级安全和合规检查AI,而无需担心设备性能限制,从而极大提升整体系统的效率和用户体验。通过将AI模型压缩至照片大小,Captur为移动端智能应用树立了全新标杆,也让我们看到了未来智能手机变得更聪明、更快速的清晰路径。随着技术不断发展与应用落地,AI将在日常生活中扮演愈加关键的角色,真正实现"轻量化、高性能、多任务"的完美统一。

。