在当今机器学习特别是自然语言处理和计算机视觉领域,嵌入模型是捕捉数据语义信息和上下文关系的重要工具。嵌入空间的质量直接影响后续任务诸如搜索、推荐和分类的效果。对比学习作为训练嵌入模型的主流方法,通过最大化正样本相似度,最小化负样本相似度,使模型能够精准地区分相似与不相似的样本。而要想训练出越优秀的对比学习模型,大批量训练的重要性逐渐显现。大批量训练提供了足够多的负样本数量,有助于构建更丰富的对比环境,从而显著提升嵌入的区分度和泛化能力。不过,传统观点认为训练大批量模型必然需要海量GPU资源和昂贵的硬件支持,这成为许多研究者和企业的现实瓶颈。

针对这一难题,GradCache技术的诞生则带来了颠覆性的突破,为有限硬件环境下的嵌入训练注入了新的活力。本文将深入解析大批量训练对嵌入模型的重要意义,详细解读GradCache的工作原理及其如何实现显存瓶颈的突破,帮助业界开发者更好理解并应用先进技术提升力作。 大批量训练为何至关重要?在对比学习框架里,常用的损失函数信息噪声对比估计(InfoNCE)依赖于批次中所有样本的相似度关系。模型需要将正样本对互相拉近,而将负样本对推远,而“负样本”的数量等于批次大小减一。批次越大,负样本数量越丰富,模型获得的对比信号越强,从而有效提升嵌入空间的分布质量和判别力。例如,像CLIP这类开创性的视觉语言模型,正是借助超大批量的负样本复用,实现了惊人的跨模态理解。

此外,大批量训练能显著降低估计方差,使得训练过程更加稳定和高效。可惜的是,将全量批次的数据和相似矩阵装入GPU显存并进行反向传播,对硬件资源提出极高要求。尤其是对个人研究者和中小型企业,这常常意味着不可踰越的门槛。 面对这一难题,很多初学者可能会尝试简单的梯度累积(gradient accumulation)来间接模拟大批量训练,即将大批次拆成若干小子批次分别计算损失和梯度,再累积后更新模型参数。然而,InfoNCE损失函数的核心问题正是它的批次内所有样本的联合依赖,简单分割批次导致负样本信息极度缺失,造成收敛效果大打折扣。这一理论上的陷阱使得梯度累积在对比学习场景难以奏效,即使显存有限,也不得不放弃大批量的优势。

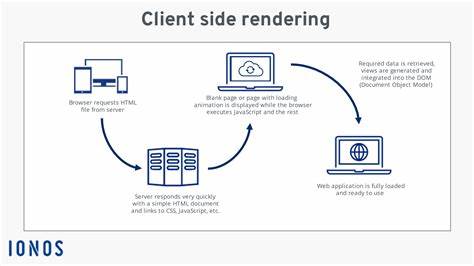

GradCache技术的提出直击这一痛点。它巧妙地将计算过程拆解成两部分:首先,无梯度追踪(no grad)的前向传播阶段计算得到全批次的嵌入向量。接着,利用这些嵌入构建完整的相似度矩阵并计算InfoNCE损失及其对嵌入的梯度,这部分不涉及大规模模型参数的存储。最后,针对每条数据样本,单独重新计算小批次的编码器前向传播,并用预先计算的梯度对模型参数进行反向传播。这样的设计极大程度消除了显存占用,因为不需保留全批次编码器的中间激活,只使用预计算的嵌入梯度完成梯度传播。 从数学角度看,InfoNCE损失的梯度相对于编码器输出(嵌入)是依赖整个批次的,但对编码器参数的梯度可分解为对单独样本嵌入的梯度乘以该嵌入对参数的导数。

利用该线性性质,GradCache避免了全批处理的激活缓存需求,只需分步针对每个样本执行轻量前向和反向过程。这类似于梯度检查点技术的变种,但针对对比学习的特殊性质进行了优化。 GradCache的优势不仅在于显存节省,更在于其允许训练者以较小硬件配置,训练出大批量规模下的高质量嵌入模型。对于中小型团队或者资源有限的研发环境,无需大规模GPU集群,也能享受到大批量训练带来的性能红利。Nomic等团队已经实验证明,使用GradCache技术训练的嵌入模型,能够以有限资源实现对标甚至超越传统大规模集群训练效果。 此外,理解GradCache的工作机理也有助于深入理解对比学习中的梯度流动特性,强化对嵌入训练中的数学细节和计算架构的把控能力。

它对开发者实践对比学习算法、设计高效训练流水线提供了宝贵思路。 在实际应用层面,大批量训练与GradCache带来的提升,在推荐系统、自然语言搜索引擎和视觉检索等多种场景具有切实价值。海量文本查询与内容匹配任务中,具备丰富负样本的嵌入模型能够更灵敏捕捉细微语义差异,提高结果精确度和用户满意度。像图像和文本等多模态联合嵌入训练,也因大批量训练更好地建模不同模态之间复杂关系,而表现出显著优势。借助GradCache降低硬件门槛,更多创新型企业和实验室得以尝试和拓展更大规模对比学习模型,快速推动产业落地。 未来,随着机器学习模型规模不断扩大以及数据需求日益增长,训练技巧与优化手段依然是推进技术应用的关键。

GradCache展现的是思想上的创新,它激励我们重新审视计算图构建、梯度流动和资源利用之间的平衡,为智能算法优化开辟新路径。结合模型剪枝、混合精度训练、多卡分布式并行等技术手段,未来训练大批量对比模型将更加高效、经济和普适。 综上,掌握并应用大批量训练策略对构建行业领先的嵌入模型至关重要。而GradCache等创新技术的涌现,则极大地扩展了普通研究者和企业实现这一目标的可能性。深刻理解其背后的数学原理和架构设计,有助于更科学地规划训练资源,优化模型效果。随着机器学习社区的不断探索与进步,相信更多类似GradCache的技术将被发明和推广,为智能时代的算法创新注入强劲动力。

无论是学术研究还是工业实战,拥抱大批量训练并突破显卡局限,必将是打造优质嵌入模型的必经之路。