人工智能助手ChatGPT因其强大的对话智能和自然语言处理能力,迅速得到全球用户的青睐。然而,2025年6月爆出的记忆隔离失败事件,令整个行业警觉。此事件涉及ChatGPT在不同会话中泄露用户输入的敏感内容,带来了隐私和数据安全的重大隐忧。作为用户和技术观察者,深入理解这一问题的根源和影响,十分必要。 记忆隔离,顾名思义,是指人工智能系统应将不同用户会话彼此独立,确保任何一个会话中输入的信息不会被其他会话访问或“看到”。这种机制不仅是保障用户隐私的关键,更是满足数据安全合规要求的基础。

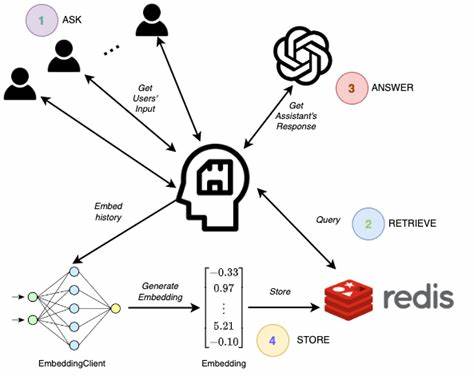

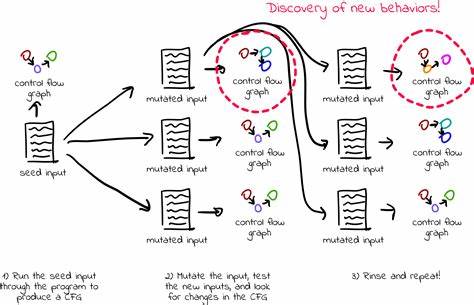

可一旦记忆隔离失败,意味着敏感信息可能在未经授权的情况下被其他用户或系统访问,造成严重泄露风险。结合曝光事件,某用户在一次会话中输入了一段特定的乱码字符串,该字符串仅在该用户与ChatGPT的这一次独立对话中出现。令人震惊的是,该字符串随后在其他多个未关闭或仍处于活跃状态的会话中被模型“读到”,并且模型对该字符串做出了特别的自动纠正处理。这种跨会话信息出现,直接折射出ChatGPT内部记忆管理和会话隔离机制的明显缺陷。 值得关注的是,这种问题并非简单的偶发现象,而可能源于底层架构设计的局限。在当前的设计框架下,ChatGPT的用户上下文存储和处理全程依赖服务器端,用户本地不保存任何持久化个人资料或上下文记忆。

官方宣称各会话相互独立且无状态,这不仅方便了系统资源管理,也声称更安全。但实际情况是,服务器端会话区分并非绝对可靠,并且缺乏有效的透明度、审计日志与异常告警,导致信息一旦“漏出”便难以追溯和修补。 这种设计的利益分配也引发了业界广泛讨论。由OpenAI维护的集中式会话管理模式,在保护系统负载的同时,却牺牲了用户对自我数据管理的控制权。用户无法查看自身数据的完整使用轨迹或导出,且遇到类似泄露事件时难以获得清晰反馈和快速响应。在一系列安全漏洞被披露后,OpenAI对外的处理态度也饱受批评。

报告漏洞的用户被建议通过Bugcrowd等众包平台提交详细文档,自行承担后续跟进重任,这暴露出企业对于用户反馈的疏忽和处理流程的不够完善。 在实际影响层面,记忆隔离失败带来的风险不可小觑。首先,用户敏感信息如个人隐私、商业机密以及医疗、金融数据可能被无关会话访问,造成信息泄露。其次,跨会话上下文误用会引发对模型回复的信任危机,影响用户体验和平台品牌信誉。此外,若攻击者故意利用该漏洞,将可能实施数据盗取、身份冒用甚至更高危的网络攻击,安全事故潜在风险极大。 面对如此严重的安全挑战,用户应当采取多方面防护措施。

避免在对话中输入高度敏感或机密信息,是目前最直接的防护手段。同时,保持对话会话的有序管理,关闭不活动会话以减少长期“悬挂”风险,也能降低数据暴露的可能性。对于企业用户,更应辅以严格的风险评估和合规控制,避免将绝对敏感业务依赖于尚未完全验证安全性的模型接口。 然而,从根本上解决ChatGPT的记忆隔离漏洞问题,需要平台全面提升自身架构设计。包括加强会话分割的技术实现,确保会话上下文绝不共享;搭建完善的日志审计和异常检测系统,保障一旦发生泄露能第一时间发现和处理;为用户提供透明的隐私政策和数据管理界面,支持数据导出及个性化隐私设置。这样的提升不仅增加用户对AI平台的信任,也为整个行业树立安全防护的标杆。

另外,推动人工智能技术监管和标准制定显得尤为重要。相关政策应指导AI平台严格执行用户数据隔离,定期公开安全评估报告,并设定明确的责任追究机制。行业内的自律与外部监管相结合,将促进健康、公正和透明的人工智能生态环境构建。 总结来看,ChatGPT记忆隔离失败事件揭示了当前AI对话系统在隐私保护和架构设计上的严重短板。虽然智能交互带来了便捷与高效,但背后的安全隐患不可忽视。只有通过技术创新、管理完善与监管配合,才能切实保障用户数据安全,实现人工智能的发展真正造福大众。

在未来,用户在追求智能体验的同时,也需保持必要的警惕和自我保护意识,共同推动AI技术向更加安全可信的方向迈进。