近年来,随着社交媒体和去中心化网络的兴起,信息流动速度与规模空前增长,也吸引了众多关注网络舆论和安全的执法机构介入。在这一背景下,使用高级文本处理工具分析服务器日志成为了解幕后真相的重要手段。尤其是Awk工具,以其简洁而强大的文本处理能力,帮助揭示了FBI通过支付爬虫公司搜索涉嫌网络骚扰者“WitchKingOfAngmar”(俗称Torswats)的秘密行动。 Awk作为一种Unix下强大的文本分析语言,以其简明的语法和高效的处理速度,成为服务器日志分析的利器。针对分布式社交平台如Fediverse(去中心化社交网络),处理成千上万条API访问日志,识别异常流量、爬虫行为、关键词匹配等,是确保网络安全和维护社区环境的关键步骤。通过对访问日志中请求频率、请求路径、请求响应码及User-Agent等字段的筛选和统计,可以甄别出隐藏在正常用户背后的恶意爬虫程序。

在针对疑似违法内容和不良用户的持续监控过程中,FBI采用了多层策略。他们通过付费给第三方数据采集公司,利用爬虫程序大规模收集社交平台上的帖子和用户信息。爬虫利用模拟正常浏览器行为,轮换IP和User-Agent,绕开传统的反爬虫机制,迅速抓取公共动态。这些原始数据经过初步的关键词过滤和情感分析,再通过诸如Facebook等大型社交平台的内部工具被整理归类,便于执法人员迅速定位潜在威胁对象。 Freely accessible的去中心化社交网络,如Pleroma或Mastodon实例,因其开放性和拥护言论自由的理念,成为边缘群体聚集的场所。同时,这也吸引了试图传播违法内容或进行骚扰的人员,特别是所谓的“Torswats”,他们以匿名方式发动恐吓、假警报等行为,严重扰乱社区秩序。

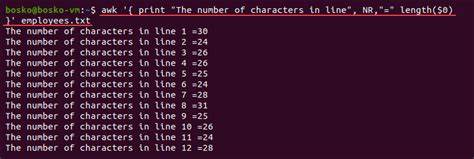

传统手段难以根治,因此借助技术力量主动采集、分析社交信息,实现精准打击成为执法重点。 分析过程中,通过设定Awk脚本,结合时间戳和请求状态码,能够实时绘制访问量的变化趋势及异常峰值。特别是在爬虫请求突然大量涌入某一敏感接口时,容易发现其异常。脚本的设计灵活,例如每秒钟统计请求数,标记成功的POST请求、失败的请求码,甚至区分来源IP,这些都是定位爬虫和数据泄露的核心手段。 有趣的是,在发现目标爬虫行为后,站点管理员采取了主动反制措施。他们生成大量无意义的虚假数据,让爬虫陷入数据迷宫,降低真实信息的有效提取。

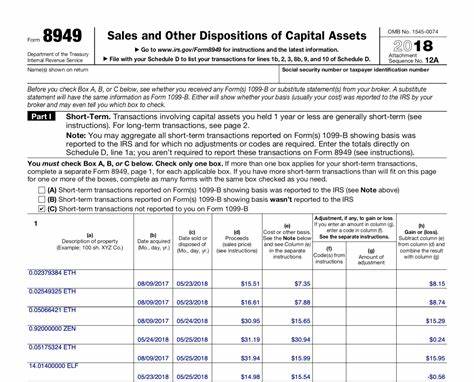

爬虫的反应被监测并展示,暴露了其对数据模式的精准识别以及异常分析能力。通过向爬虫注入特定关键词,如“larry fink”,甚至能触发其背后数据分析链路上的目标响应,进一步证明了数据采集的真实目的。 此行动背后的公司BoardReader与其母公司SocialGist,一开始对外否认违规数据采集行为,但其爬虫流量和访问特征持续被发现绕过制约机制。尽管管理层对话存在沟通,但爬虫似乎完全未停止其对数据的索取。最终,管理员利用持续制造干扰、故意注入敏感信息,成功迫使对方回应并退出相关索引。 整个事件的关键节点,则是通过拼接用户身份“WitchKingOfAngmar”和相关威胁言论定位到近邻美国加州的Alan Winston Filion。

此人因以网络匿名身份发起无数假炸弹威胁和虚假人质事件,被称为“Torswats”,乃是执法部门重点追查的目标。通过这一过程,FBI的付费爬虫网底体系浮出水面,揭示了现代网络监控利用技术与数据中转形成的复杂链条。 这起案例不仅展现了技术如何帮助揭露网络匿名骚扰者,更暴露了执法机构与技术公司之间模糊的监督和合规边界。第三方数据采集为FBI提供了宝贵信息渠道,却也带来了隐私安全和信息真实性的争议。此外,Facebook等巨头在数据链路中扮演的角色进一步引发公众对平台责任和国家安全合作的关注。 对于一般服务器管理员,如何利用Awk等工具分析和监控访问日志,是提升自身防御能力的实用建议。

Awk几乎是文本数据管理的“SQL”,灵活地从巨量日志中提取关键信息,识别流量模式和异常,有效提升服务器的安全感知和响应效率。同时,了解爬虫行为特征,如IP多变、UA伪装、请求速率异常等,有助于建立更加精准的防护策略。 这一事件也警示了去中心化社交网络的潜在风险。尽管它们致力于保护表达自由和用户隐私,但这可能成为不法分子活动的温床。社区管理员应设定合理的规则和技术屏障,及时监控异常行为,防止犯罪内容渗透,保障广大用户的安全和平台的健康成长。 总体来看,利用Awk等开源工具揭秘FBI利用爬虫追踪Torswats的过程,展现了数据驱动执法的新趋势和挑战。

技术赋能的同时也带来伦理和隐私上的讨论。未来,如何在开放网络生态与安全监管之间找到平衡,将成为技术发展和社会治理必须共同面对的课题。持续加深对日志分析的理解和应用,不仅能帮助管理员维护良好的社区环境,也为公众认识网络安全态势提供了真实而鲜活的案例参考。